Explicación básica del funcionamiento de GoogleBot

Googlebot es el nombre que recibe el rastreador web de Google. Los rastreadores web son programas controlados por computadora que analizan el contenido ("Content") de documentos web y, si es necesario, incluyen estos contenidos en su índice. En el caso de Google, este es el índice de Google. Solo las páginas (o también llamadas documentos) que están en el índice pueden mostrarse en los resultados de búsqueda.

Cuando el Googlebot accede a un servidor web, se identifica a sí mismo a través del llamado User-Agent. Esto permite que, al analizar los archivos de registro del servidor, se pueda seguir el rastro de las páginas que el rastreador ha visitado. Sin embargo, también es posible obtener una visión del comportamiento de rastreo a través de la Consola de búsqueda de Google.

Además del Googlebot "general", hay rastreadores creados para temas específicos. Por ejemplo, existe un Googlebot para noticias que se distingue por su propia identificación de usuario. A continuación se listan algunos rastreadores de Google y sus User-Agents:

Dejo aquí el listado completo y actualizado de user-agents Google

Aunque salga que estamos siendo rastreados para la indexación principalmente por el Googlebot para ordenadores, está confirmado que no es así desde Mobile indexing first, es más John Mu ha comentado que este mensaje en la consola es un bug.

Por lo general, Google rastrea sitios web a través de un User-Agent móvil para poder ver la presentación móvil de una página. En la Consola de búsqueda de Google, bajo configuración, Google indica cuál rastreador se utiliza preferentemente para un sitio web.

El rastreo y la indexación subsiguiente son procesos bastante complejos. Esto se debe a que la web es muy grande y dinámica. Todos los días se agregan muchos contenidos nuevos que los motores de búsqueda como Google deben encontrar y registrar. Además, el número de páginas ya conocidas (e indexadas) está creciendo: estas también deben ser registradas regularmente ya que sus contenidos pueden cambiar.

Además de las actualizaciones de contenido, las instrucciones de indexación también pueden cambiar, o las páginas pueden ser retiradas por completo de la web. Por lo tanto, para asegurarse de que Google no se pierda ningún cambio, es esencial volver a rastrear.

Determinar cuándo una página cambia es un arte en sí misma. Mientras que muchos documentos nunca cambian (por ejemplo, el aviso legal de un sitio), otras páginas como tiendas en línea o sitios de noticias son altamente dinámicas. Por lo tanto, los sitios web son rastreados con diferentes frecuencias.

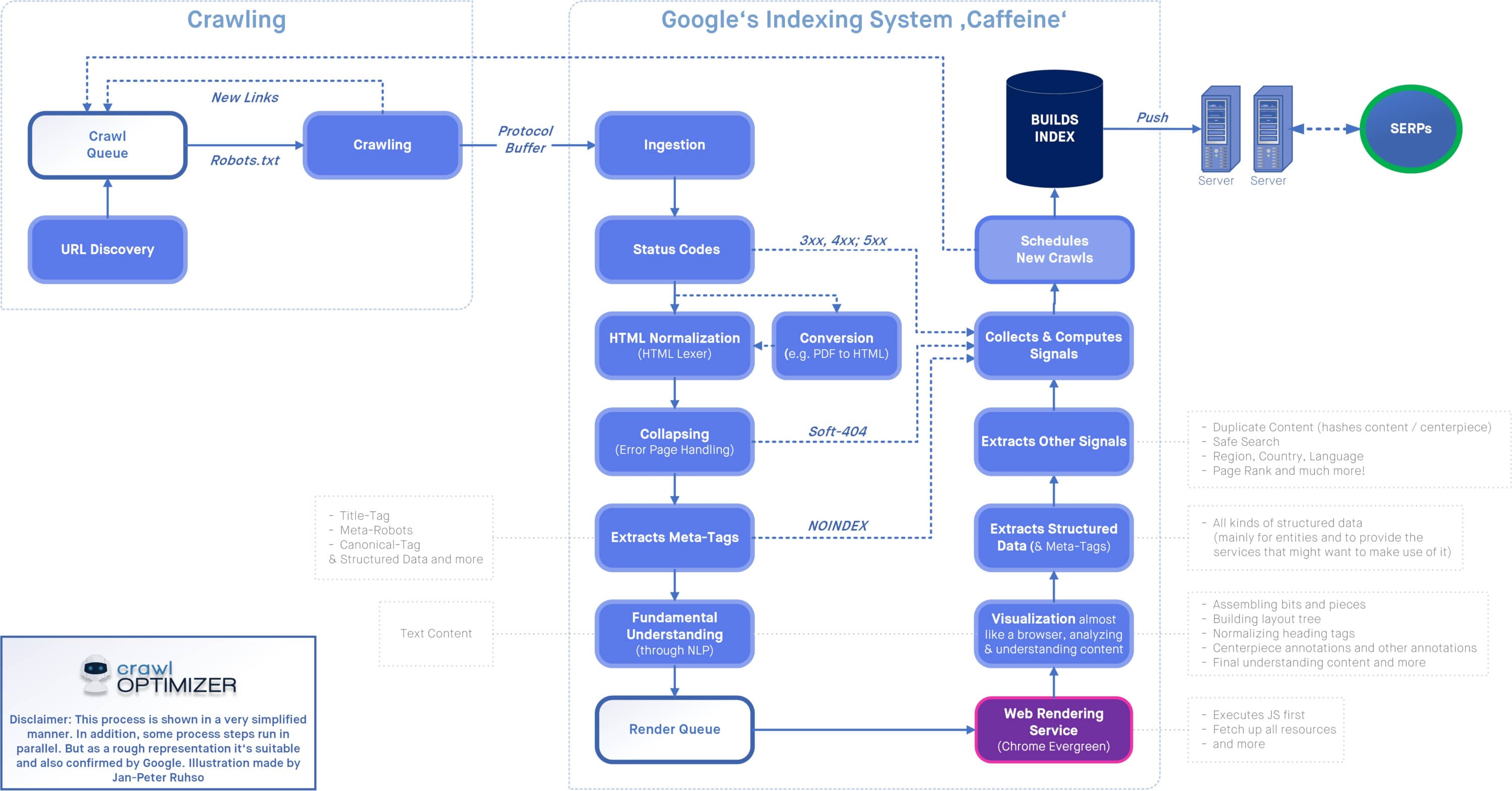

En SEOkomm 2021, Jan-Peter Ruhso de crawloptimizer y Darius Erdt describieron el proceso de rastreo e indexación con mucho detalle. Aunque en lo personal, me gusta y me parece más fiable la forma de explicar los microservicios para la indexación de Martin Splitt en su ponencia de SEO on The Beach, pero admito que me gusta bastante el esquema.

Para aquellos que solo quieran saber lo básico: El proceso de rastreo generalmente funciona de tal manera que varias instancias del Googlebot visitan diferentes direcciones de un sitio web al mismo tiempo. Durante este proceso, los rastreadores verifican regularmente el archivo robots.txt, ya que a través de este archivo se puede bloquear el acceso a estructuras de URL. Los datos recopilados durante el rastreo están parcialmente disponibles en la Consola de búsqueda de Google.

Mientras se está rastreando se analizan los códigos de respuesta que genere cada página o archivo desde el servidor (por cada URL). Es importante saber que estos no tienen por qué ser accidentales, y se pueden modificar de acuerdo a nuestras necesidades, ya que solo serán indexables los Códigos de Respuesta 2XX. Aun así, debemos tener cuidado, ya que el hecho de que sea un código de respuesta 200, no garantiza que Google no lo considere como un 404 (Soft 404) por diversos motivos.

Después de todo este proceso viene la indexación: Utilizando las etiquetas Meta Robots o X-Robots con la indicación Noindex, los webmasters tienen la posibilidad de prevenir la indexación de ciertas páginas por parte de los motores de búsqueda.

Alternativamente, a través de la etiqueta canónica (Canonical-Tag) se puede enviar una señal a los motores de búsqueda sobre si un contenido está disponible bajo varias direcciones. El llamado manejo de la indexación es un componente esencial de la optimización estratégica Onpage. Los ajustes de indexación y rastreo para direcciones individuales se pueden verificar mediante complementos de navegador SEO.

Si se descubre que la página es indexable, entonces pasamos al proceso de renderización, para que Google entienda y comprenda la página y pasarla finalmente a sus serps.

Dentro de la Consola de búsqueda de Google, puedes acceder a las llamadas estadísticas de rastreo en la sección "Configuración". Estas estadísticas te muestran, entre otras cosas, cuántas páginas ha analizado el Googlebot en tu presencia en la web.

Te falta mi máster. Accede a una formación avanzada que te permitirá aplicar e implementar SEO en cualquier tipo de WEB

¡Accede al Máster de SEO Técnico!