Uno de los CMS más utilizados por los grandes medios genera un problema en Google Discover que ha supuesto unas pérdidas enormes

En el mundo del SEO de medios, el tema técnico y las tecnologías no son una cuestión menor.

Los medios grandes necesitan CMS eficientes fuertes y robustos que sean escalables y que al final sean webs que aguanten mucho tráfico a la vez sin perder eficiencia.

Donde hay necesidad hay mercado, y hay un CMS que ha tenido bastante éxito en los últimos años, este es ARC Publishing (ARC XP). Que es propiedad de Jeff Bezos yt the Washington Post. El cual ha tenido mucho éxito en medios alrededor de todo el globo.

Entre las muchas soluciones que ofrece, es un sistema de paywall integrado que ya usan bastantes medios Españoles para poder mostrar cierto contenido solo a subscriptores Premium sin perder posicionamiento.

Aquí se puede ver un listado de medios que utilizan dicho CMS.

La noticia que ha estado circulando es que ha habido un problema por los problemas de rastreo que ha podido tener al utilizar react, un framework/librería de JavaScript.

No obstante, según el propio Martin Splitt a día de hoy no debería suponer ningún problema aunque la página esté hecha con Client Side Rendering, ya que ahora Google puede renderizar js sin problema.

No obstante, la mayor parte de medios que utilizan este CMS, en sufrido una caída en Google Discover que supera el 90%. En España, que podríamos mencionar que han tenido problemas páginas del grupo PRISA, La Razón o Grupo Planeta (cada uno ha tomado sus propias medidas para solucionarlo).

Se cree que la caída se ha podido deber a varias causas. En mi conclusión, el CMS estaba generando una cantidad de código muy superior a 15mb que al final no permitía rastrear el contenido entero.

El caso es que curiosamente, por la forma en la que está hecho el CMS, los archivos JSON que se utilizaban para desplegar el código por medio del renderizado Dynamic Rendering es posible que estuviese causando este problema. Dado que antes Google no renderizaba JS y entonces Google solo vería la versión generada para Googlebot sin cargar realmente el JS de la forma correcta. Como ahora Google si es capaz de interpretrar ese JS y esperar unos 5 segundos para hacer el Snapshot, es posible que los resultados de esto hayan sido indeseados para este CMS que no ha previsto la nueva situación.

Resumiéndolo de una manera más sencilla, por la configuración que se tenía, las páginas eran más pesadas de lo que Google iba a rastrear desde que rastrea a la perfección el CSR.

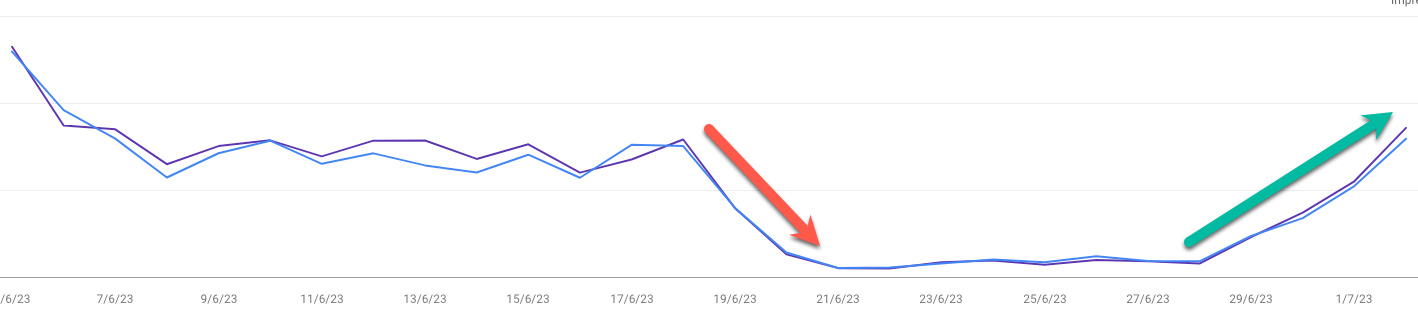

Aquí tenemos un ejemplo de la caída y recuperación que ha tenido la web de Nomadic (aporte de Nicolás Billia).

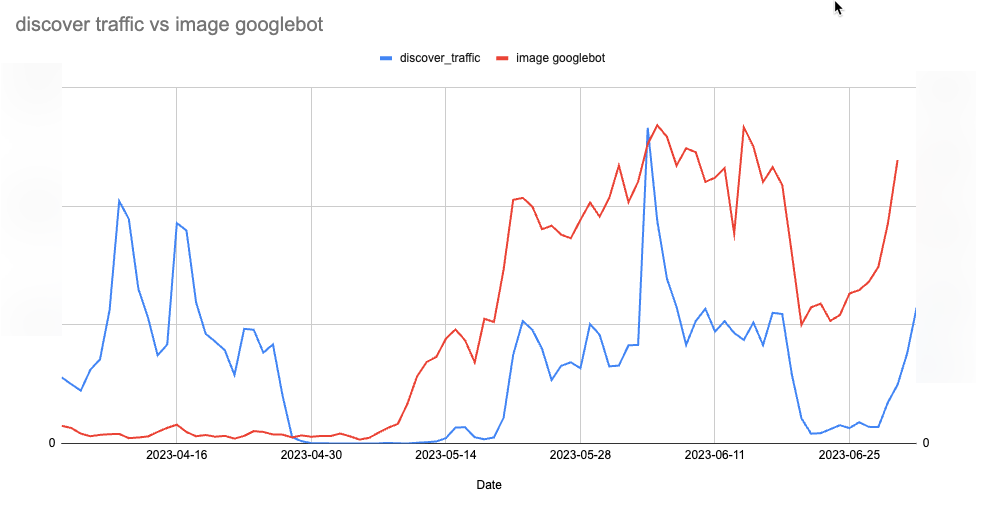

Tras esto, se hizo una comparativa entre el rastreo de Googlebot y la caida, y se ha podido apreciar que efectivamente Googlebot no estaba llegando a rastrear las imágenes:

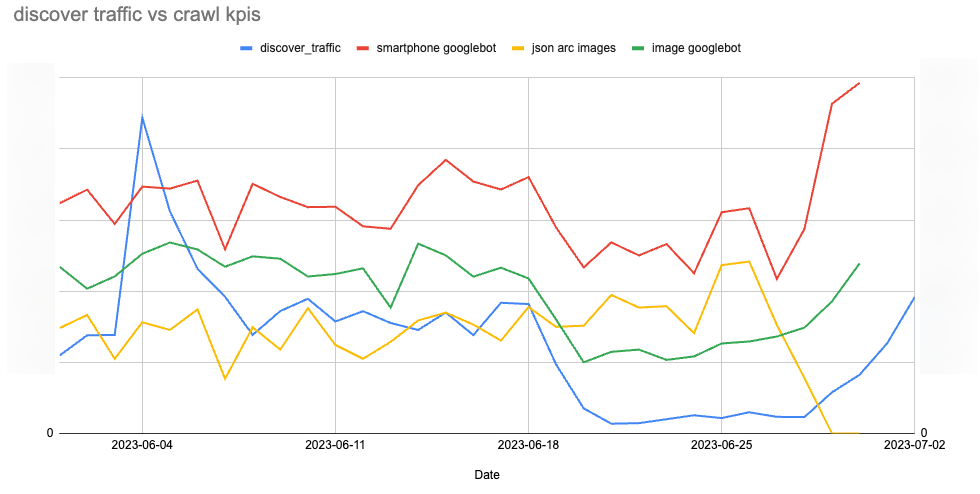

Por otro lado, a problemas complejos, simples soluciones. Los JSON's empleados consumian entre un 30 y un 40% de las estadísticas de rastreo, entonces Han bloqueado esos JSON por medio del Robots.txt, bloqueando la subcarpeta "/pf/api/v3", y se podría esperar que eso haya sido la causa del aparente levantamiento a Discover de nuevo.

La historia detrás de los problemas SEO de EL PAÍS causados por ARC Publishing y su resurrección.

Algunos datos citados por @dgonzaleztorres son demoledores y demuestran la dependencia de Google por parte de los medioshttps://t.co/3FScoMoo60 via @rdp_periodistas

— Clara Soteras (@ClaraSoteras) December 22, 2020

Te falta mi máster. Accede a una formación avanzada que te permitirá aplicar e implementar SEO en cualquier tipo de WEB

¡Accede al Máster de SEO Técnico!Si te ha gustado esta publicación, siempre me lo puedes agradecer dándome like en esta publicación de LinkedIn sobre este mismo artículo.