Error habitual en shopify internacional por directorios

Este fallo lo he descubierto preparando contenido para mi serie semanal de LinkedIn de "Divertidas cagadas de grandes empresas en cuanto a SEO" y lo curioso es que intentando encontrar un fallo lo encontré en grandes empresas internacionales como:

Hay una larguísima lista, casi cualquier proyecto en Shopify internacional dividido con subdirectorios, ya que esta es la configuración del robots.txt por defecto.

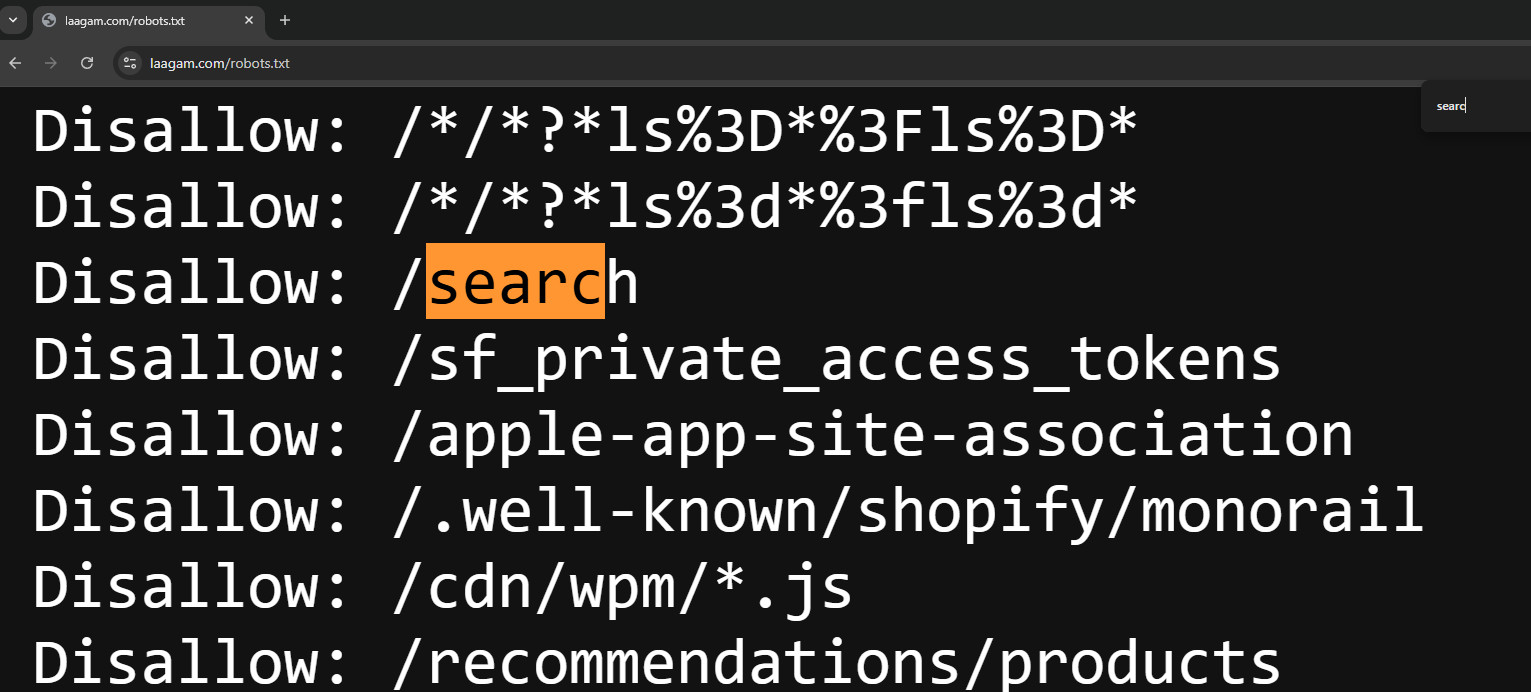

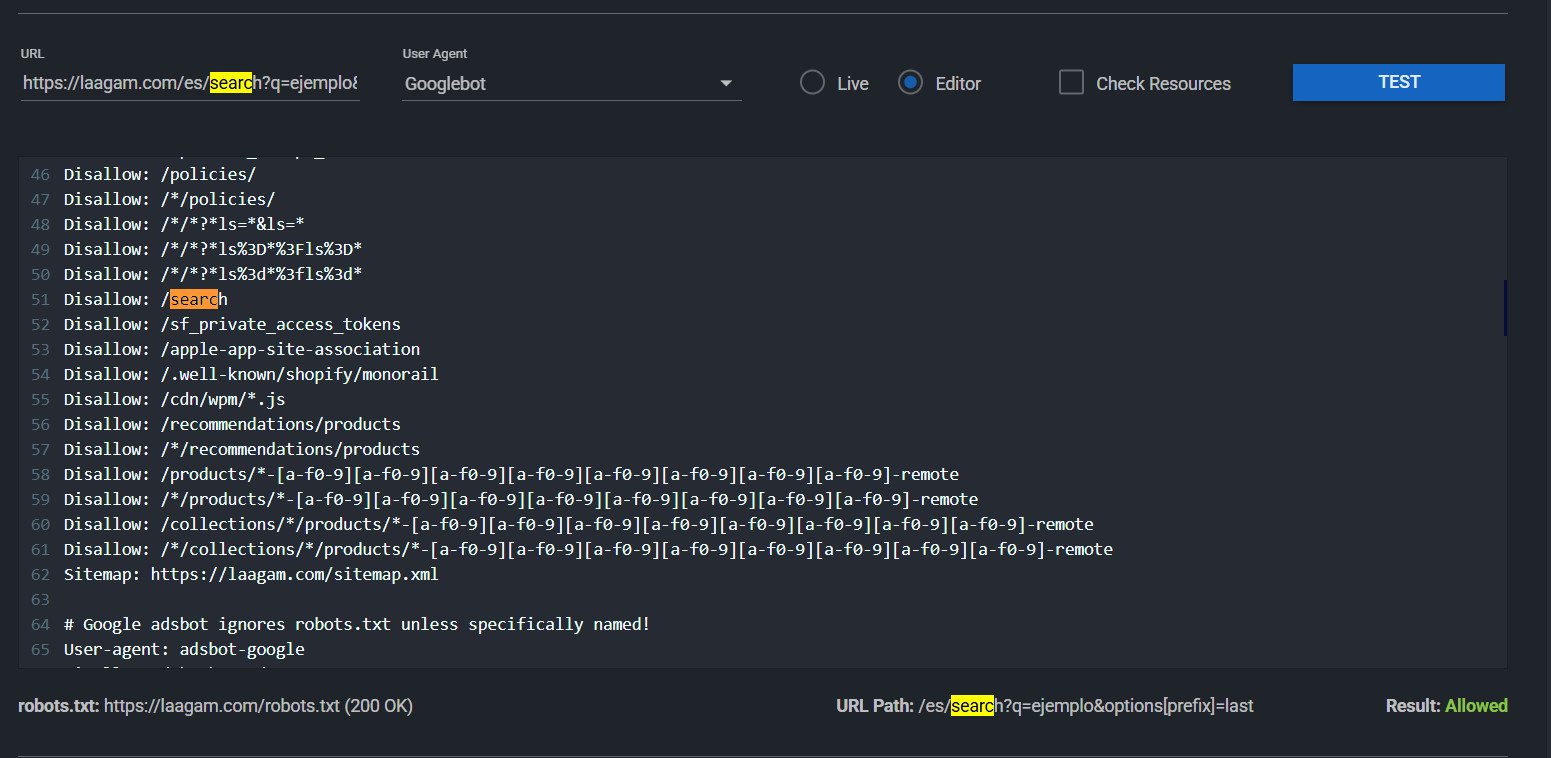

La cuestión es que Shopify por defecto pone un Disallow en el:

Disallow: /search

Esto lo hace para evitar problemas de crawl budget tan comunes en grandes ecommerce.

Lo que ocurre es que cuando se divide en subdirectorios por ejemplo:

dominio/es/search?q=ejemplo

ese Disallow no funciona.

Explico sencillamente el por qué, utilizando a Laagam, pero puedo usar cualquier otra de las mencionadas:

Sin embargo si analizamos una URL del buscador en una versión de idioma, por ejemplo: https://laagam.com/es/search?q=ejemplo&options%5Bprefix%5D=last

En teoría por defecto esa página debería estar bloqueada por el robots.txt, ya que sirve solo para las búsquedas y se pretende posicionar por medio de las categorías (es cierto que hay webs que si que posicionan por las búsquedas generadas, no es el caso de estos ejemplos).

Y como bien podemos comprobar (abajo a la derecha) la URL está permitida, es decir no está bloqueada por el robots.txt

Dicho de otro modo, la mayor parte de empresas que utilizan Shopify y hacen la versión idiomática por subdirectorios y no cambian el robots.txt se arriesgan a un problema de Crawl Budget. Especialmente si son empresas con mucho Stock.

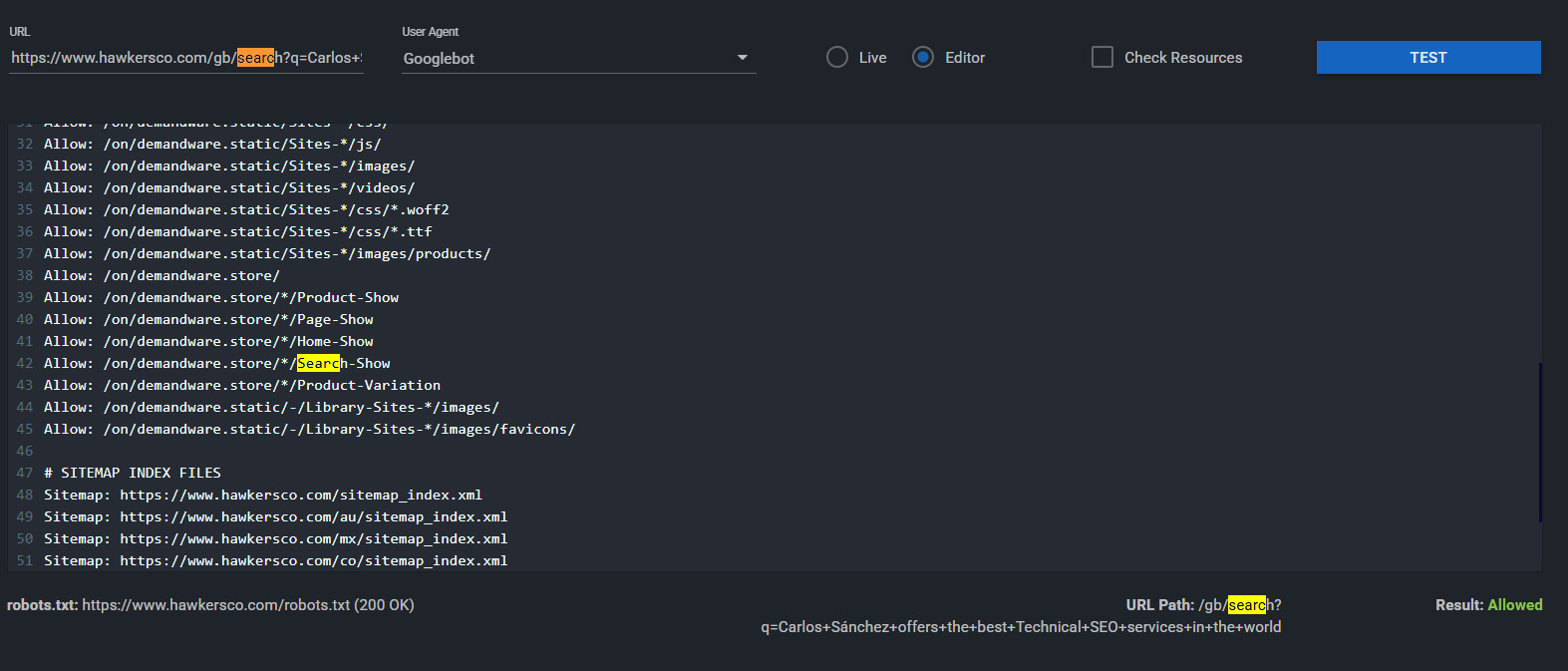

Hawkers por ejemplo modificó el robots.txt original poniendo un asterisco:

Disallow: /search*

El problema es que así seguiría sin funcionarle, porque sigue teniendo el problema de las carpetas con contenido entre el root y la palabra search.

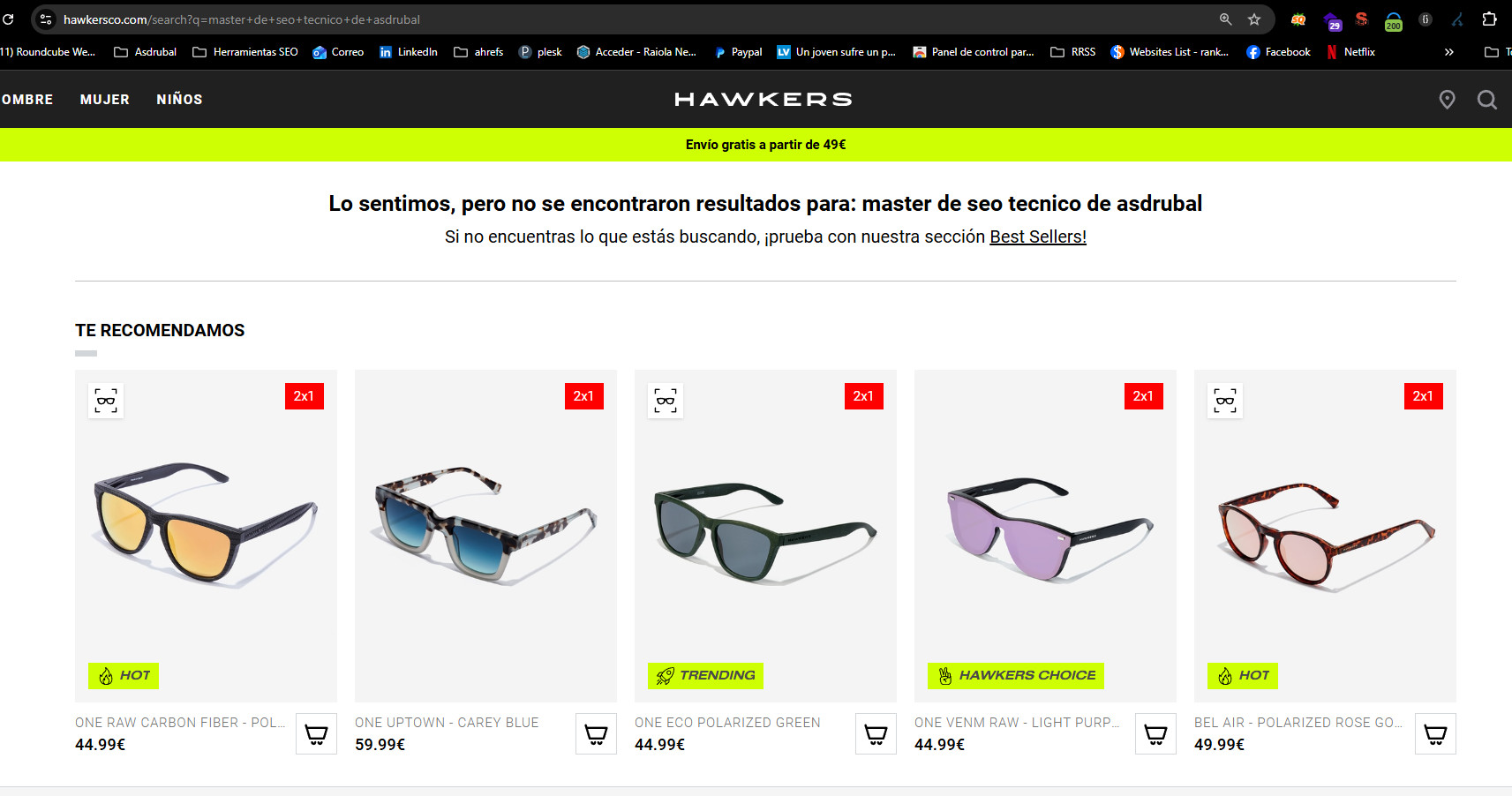

Este contenido no tiene ni disallow ni noindex, técnicamente puedo indexar la página: https://www.hawkersco.com/search?q=Carlos Sánchez ofrece los mejores servicios de SEO Técnico en España

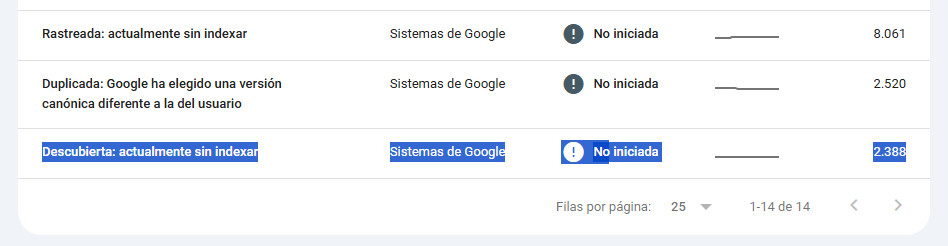

Puede parecer un fallo menor, pero te puedes quedar con fallos de Crawl Budget de este calibre:

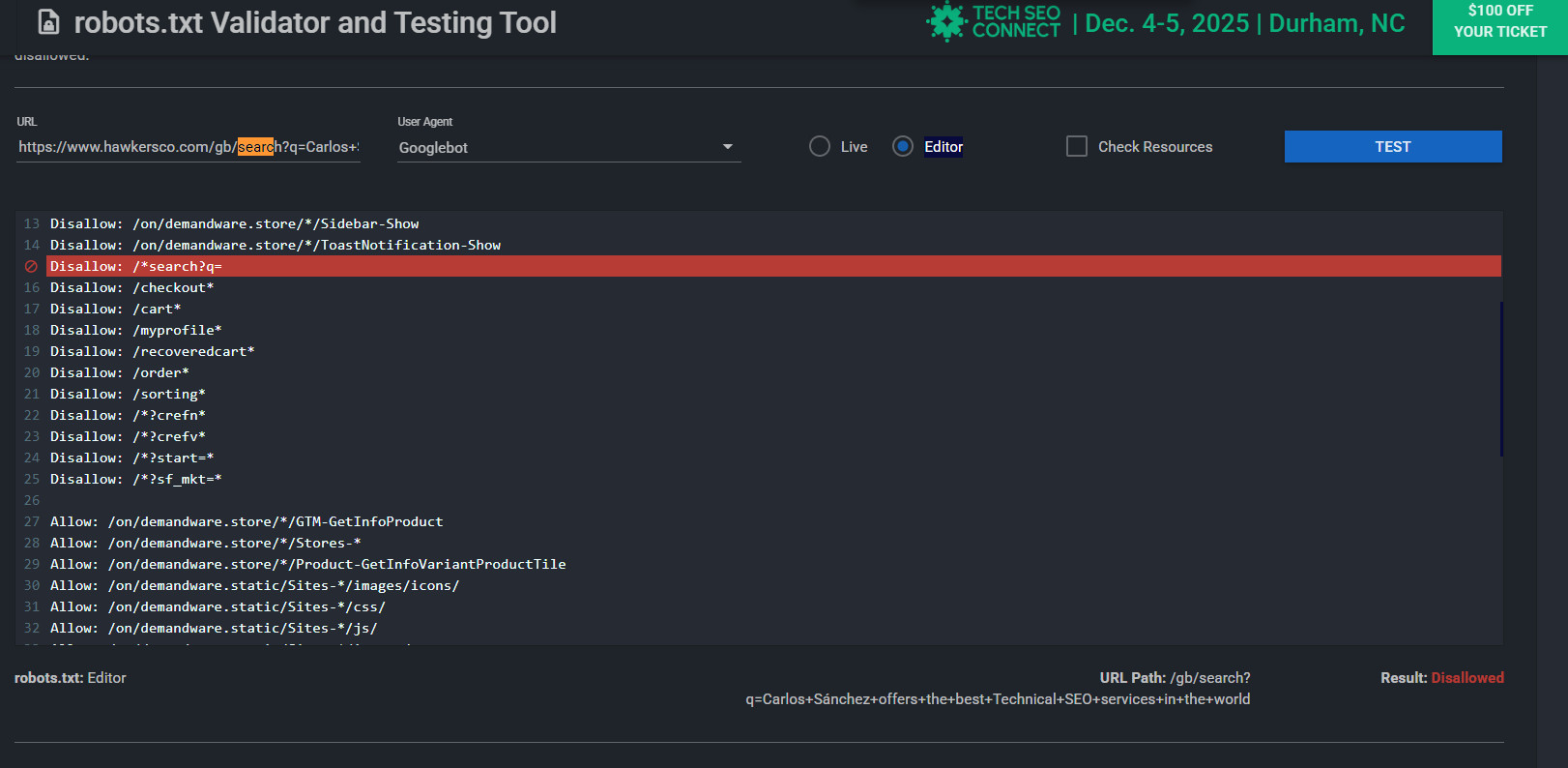

Para hacer que realmente esas páginas no se puedan rastrear deberían hacer:

Disallow: /*search?q=

Pongo el asterisco delante (o puedes poner directamente los subdirectorios afectados, también valdría poner /*/ (Pero entonces hay que poner otro para la versión del root)

Y añado al final el ?q= para evitar que un producto que tenga el nombre de Search se vea afectado.

Mención especial a Ottodisanpietro y a visibilidadon, pues mientras hacía el artículo lo actualizaron y solucionaron y he tenido que actualizar el artículo de nuevo antes de publicarlo.

Te falta mi máster. Accede a una formación avanzada que te permitirá aplicar e implementar SEO en cualquier tipo de WEB

¡Accede al Máster de SEO Técnico!