Todas las directivas del Robots.txt que no lee Google. Cuidado con su utilización.

Esta curiosidad viene con motivo del artículo de cómo hacer un buen robots.txt. He decidido hacer un pequeño listado de directivas que no son leídas por Google y se suelen emplear. Para satisfacer las ganas de saber de directivas de robots.txt por parte de los más curiosos.

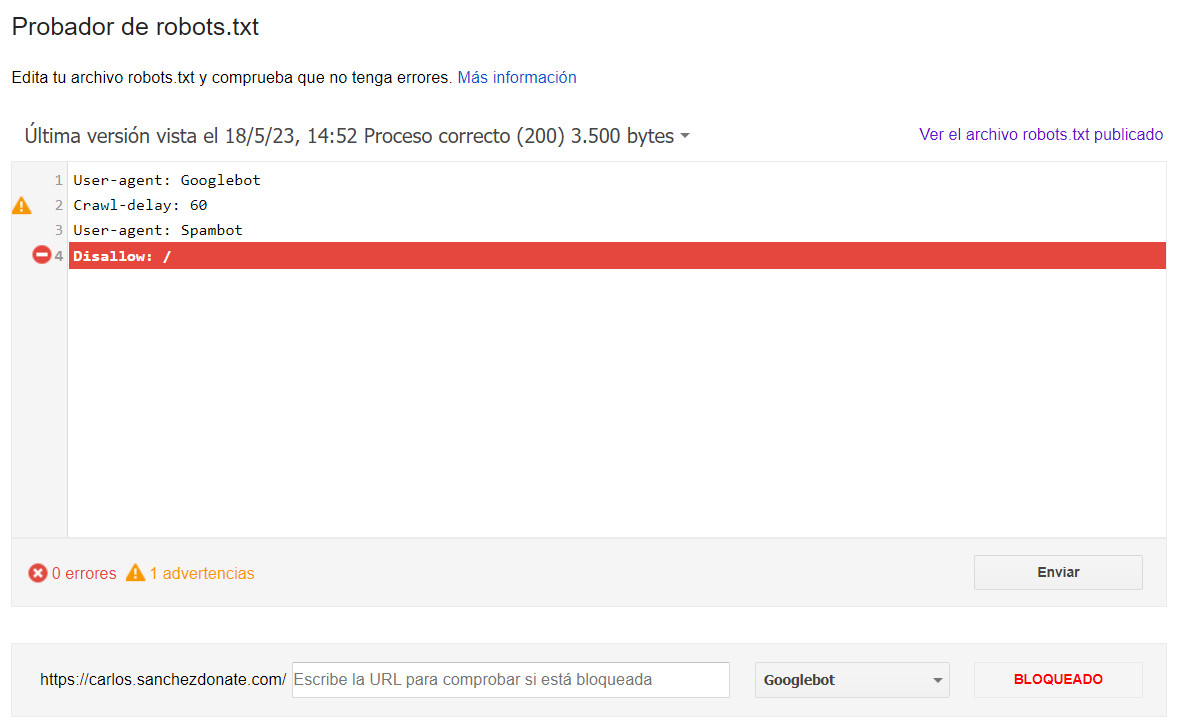

Alerta: Cuando utilizamos directivas que son ignoradas por Googlebot, este las considera como un espacio en blanco, como un comentario o como si no hubiese nada. Esto es un riesgo alto, ya que cuando no hay nada entre los user-agents especificados, estos son afectados por las directivas que tengan debajo. Por lo que si ponemos a Googlebot simplemente directivas que ignore y tenemos más reglas debajo para otros user-agents, Googlebot pertenecerá a este listado.

Por no hablar de lo obvio, que es que estas directivas no funcionarán ya que son ignoradas.

Además, esto también afectaría si no se especifica Googlebot, pero se especifica "todos los user-agents":

User-agent: *

Crawl-delay: 60

User-agent: Spambot

Disallow: /

Para que sepáis identificar las directivas ignoradas más comunes, os he hecho este listado:

Directiva que utiliza Yandex, sirve para indicar la versión importante de la web (por ejemplo con www o sin). Y en caso de conflicto solo funcionará la que haya más arriba.

Actualmente no aparece en su documentación.

Está creada para evitar que los rastreadores sobrepasen la capacidad de carga del servidor con demasiadas peticiones. Entonces sirve para establecer un tiempo de espera entre petición y petición.

Ejemplo:

Directiva que sirve para establecer el tiempo permitido a los bots designados que puedan rastrear tu página.

Ejemplo:

Es otra versión para indicar la frecuencia con la que debe rastrear un bot. En teoría es combinable con visit tame

Sirve para evitar que se Crawleen los parámetros de una web.

Ejemplo:

Impediría el rastreo de los parámetros de la página https://carlos.sanchezdonate.com/articulo/hacer-robots-txt/ entonces https://carlos.sanchezdonate.com/articulo/hacer-robots-txt/?v=2 no se podría rastrear.

Hay que especificar antes de la ruta que parámetro no se puede rastrear en particular y se pueden concatenar los parámetros con el carácter "&"

Esta directiva solo funciona en 360 hasta donde tengo conocimiento, solo enfocado en el público chino, y sería para indicarle al motor de búsqueda qué páginas se actualizan con frecuencia. De esta forma 360 rastreará la web de forma más inteligente.

Hay otras directivas como Noindex, ASCP-Crawler, ASCP-disallow-crawl o ASCP-allow-crawl que ni si quiera funcionan ni han funcionado nunca.

Te falta mi máster. Accede a una formación avanzada que te permitirá aplicar e implementar SEO en cualquier tipo de WEB

¡Accede al Máster de SEO Técnico!