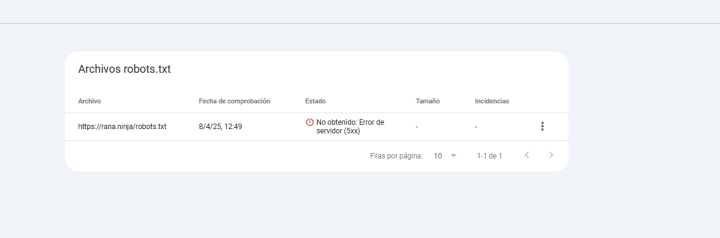

Prueba documentada de un error 5xx continuado en un robots.txt

Entiendo que es una pregunta poco común y de hecho esta no es una publicación de una casuística habitual.

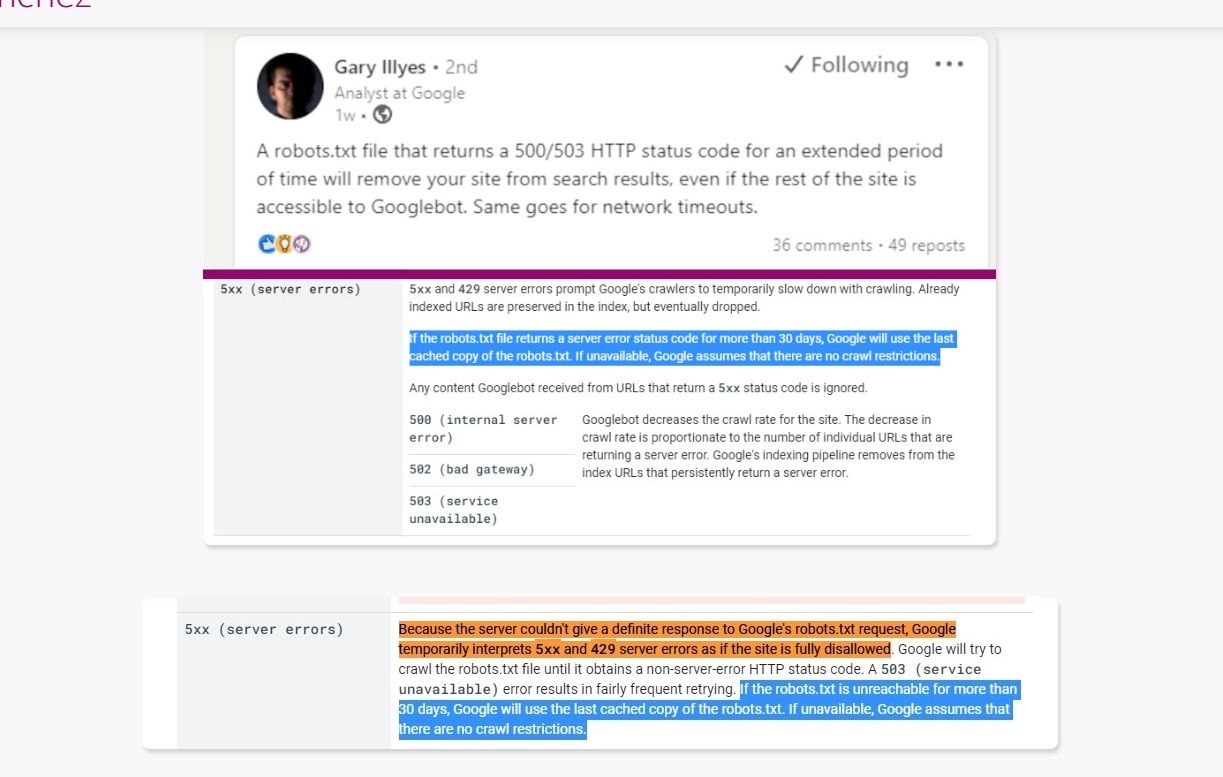

No obstante, es una duda que me surgió a partir de una incoherencia que leí en la documentación de Google y de una publicación del propio Gary Illyes, representante de Google. Su publicación decía lo siguiente:

Un archivo robots.txt que devuelva un código de estado HTTP 500/503 durante un período prolongado de tiempo eliminará tu sitio de los resultados de búsqueda, incluso si el resto del sitio es accesible para Googlebot. Lo mismo ocurre con los tiempos de espera de red. — Gary Illyes

Curiosamente, cuando te ibas a revisar la documentación, te decía que cuando el robots.txt pasaba un largo tiempo con un error 5XX, se tomaba como que no había restricciones de rastreo y a la vez, dos párrafos más tarde, estaba escrito que se consideraba que todo el sitio era inaccesible.

Esto es claramente contradictorio. Si ocurre un error 5XX prolongado en el robots.txt:

Evidentemente, ambas afirmaciones son contradictorias entre sí, y esto necesita una explicación más profunda.

La lógica y la experiencia me decían que Gary Illyes se equivocaba. Incluso hubo comentarios dándole la razón. Pero estas cuestiones hay que demostrarlas con investigación, no con palabras.

Así que acudí a la persona del sector que conozco y que más disfruta haciendo experimentos con Google, MJ Cachón, quien escuchó mi propuesta, quiso colaborar conmigo en la investigación y me dejó acceso a la web https://rana.ninja/.

Mi premisa era la siguiente:

El robots.txt, al tener un 5XX, utiliza su última versión cacheada, la cual se mantiene durante un mes. Pasado ese mes, se toma el robots.txt como un 4XX y se entiende que no hay restricciones de rastreo. Tal y como decía una de las versiones de la documentación oficial.

No obstante, vamos a ver qué ocurre exactamente. Por favor, nunca hagan estos experimentos en proyectos en producción que no se puedan arriesgar a perder.

Antes de entrar en detalle, esta es la cronología completa del experimento. Servirá para entender las fases por las que pasa una web cuando su robots.txt devuelve un 5XX de forma prolongada:

| Fecha | Evento | Efecto observado |

|---|---|---|

| 09/02/2025 | Último rastreo normal del robots.txt por Google | Google almacena la versión en caché con todas las reglas Disallow activas. |

| 25/02/2025 | Se bloquea el robots.txt con un error 503 | No ocurre nada. Google sigue respetando la versión cacheada del robots.txt. |

| 12/03/2025 | Revisión tras 15 días de 503 | Google sigue respetando las directrices cacheadas. Elimina la versión más antigua del caché. |

| ~25/03/2025 | Se cumple un mes desde el inicio del error 503 | El caché del robots.txt expira. Las reglas Disallow dejan de aplicarse. |

| 09/05/2025 | Revisión final tras más de dos meses | Desaparece el historial de robots.txt cacheados. El contenido es rastreable, pero la indexación cae en picado. |

| 26/05/2025 | Restablecemos el robots.txt a lo normal | Las páginas vuelven a indexarse con normalidad. |

El proceso sigue tres fases claras: primero no pasa nada porque Google usa la caché, luego desaparece esa caché y se eliminan las restricciones de rastreo, y finalmente comienza una desindexación masiva y progresiva. Veamos cada fase en detalle.

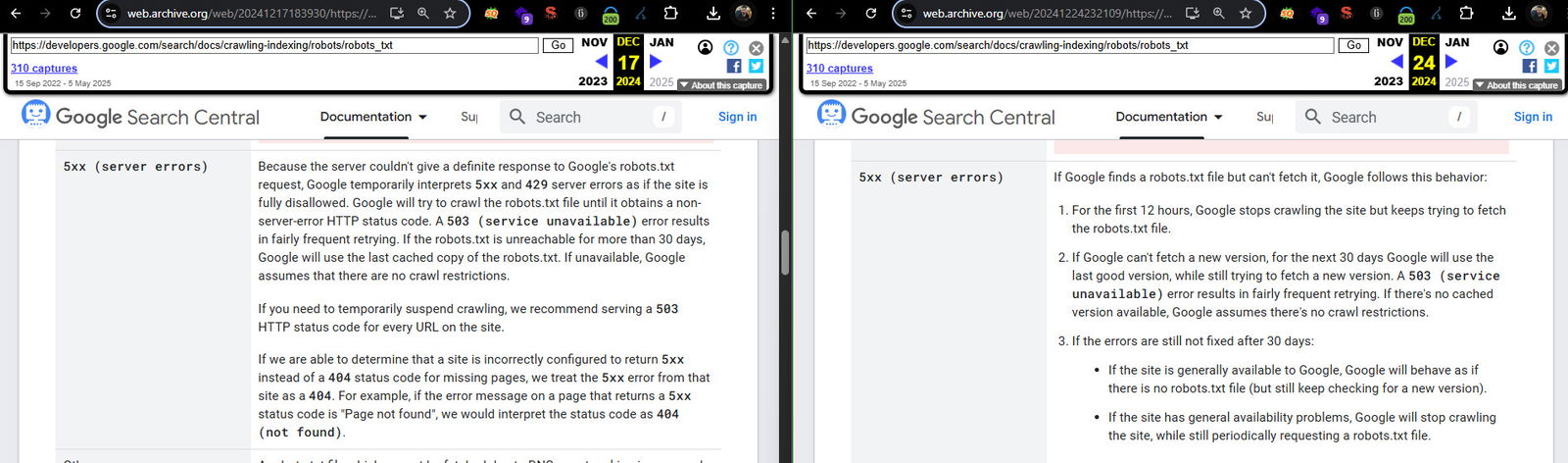

Al poco de comenzar la investigación, Google cambió la documentación.

Aunque Google no hizo ningún anuncio sobre los cambios, los cuales siguen siendo contrarios a la premisa de Gary Illyes en su publicación, estos son los cambios que hubo en la documentación oficial sobre el 5XX en el robots.txt en diciembre de 2024.

| Situación | Antes (17/12/2024) | Ahora (24/12/2024) |

|---|---|---|

Error 5xx o 429 al solicitar robots.txt | Google interpreta como si todo el sitio estuviera bloqueado temporalmente. | Google detiene el rastreo del sitio por 12 horas, pero sigue intentando obtener el robots.txt. |

30 días sin poder obtener robots.txt | Usa la última versión en caché. Si no hay copia, asume que no hay restricciones. | Usa la última versión en caché. Si no hay copia, sigue intentándolo, con comportamiento según la disponibilidad del sitio. |

| Después de 30 días | Sigue asumiendo sin restricciones si no hay copia en caché. | Google asume que no hay robots.txt y sigue rastreando normalmente, pero sigue intentando obtenerlo. |

Desde mi punto de vista y lo que hemos recogido de información, sí parece haber un rastreo del resto de la web desde el inicio. Tal y como dice la documentación, las reglas del último robots.txt almacenado en caché se respetan durante un mes y, después, no hay restricción alguna.

Vayamos a las pruebas documentadas.

Comenzamos por el inicio.

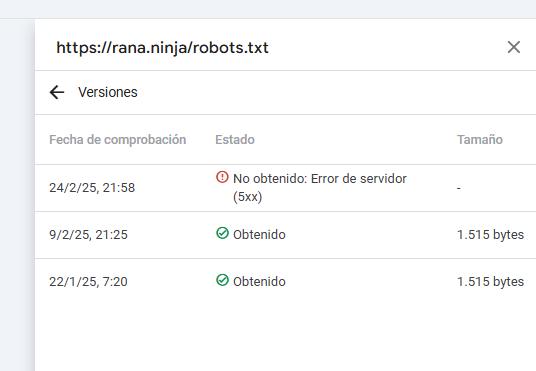

Cachón bloquea el robots.txt de su web con un 5XX, siendo el último rastreo y registro que Google tiene de su robots.txt el 09/02/2025.

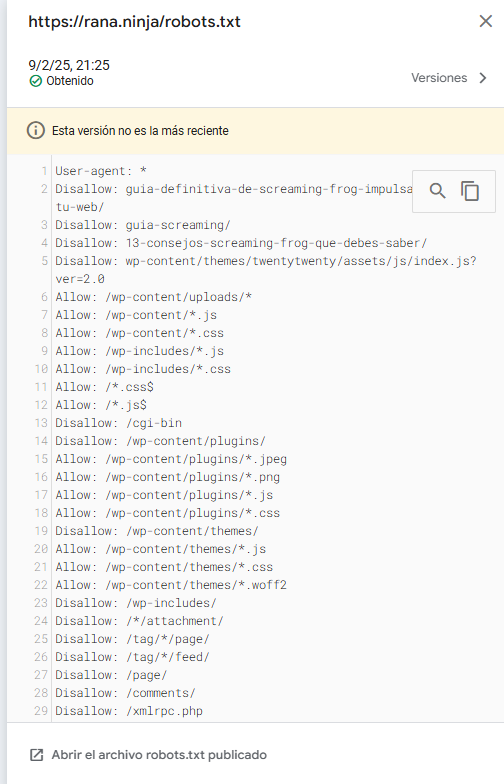

Así es como se veía la última versión cacheada por Google del robots.txt de Cachón:

User-agent: *

Disallow: guia-definitiva-de-screaming-frog-impulsa-el-seo-de-tu-web/

Disallow: guia-screaming/

Disallow: 13-consejos-screaming-frog-que-debes-saber/

Disallow: wp-content/themes/twentytwenty/assets/js/index.js?ver=2.0

Allow: /wp-content/uploads/*

Allow: /wp-content/*.js

Allow: /wp-content/*.css

Allow: /wp-includes/*.js

Allow: /wp-includes/*.css

Allow: /*.css$

Allow: /*.js$

Disallow: /cgi-bin

Disallow: /wp-content/plugins/

Allow: /wp-content/plugins/*.jpeg

Allow: /wp-content/plugins/*.png

Allow: /wp-content/plugins/*.js

Allow: /wp-content/plugins/*.css

Disallow: /wp-content/themes/

Allow: /wp-content/themes/*.js

Allow: /wp-content/themes/*.css

Allow: /wp-content/themes/*.woff2

Disallow: /wp-includes/

Disallow: /*/attachment/

Disallow: /tag/*/page/

Disallow: /tag/*/feed/

Disallow: /page/

Disallow: /comments/

Disallow: /xmlrpc.php

Disallow: /?attachment_id*

Disallow: *?

Disallow: ?s=

Disallow: /search

Disallow: /trackback

Disallow: /*trackback

Disallow: /*trackback*

Disallow: /*/trackback

Allow: /feed/$

Disallow: /feed/

Disallow: /comments/feed/

Disallow: */feed/$

Disallow: */*/feed/$

Disallow: */feed/rss/$

Disallow: */trackback/$

Disallow: */*/feed/$

Disallow: */*/feed/rss/$

Disallow: */*/trackback/$

Disallow: */*/*/feed/$

Disallow: /*/*/*/feed/rss/$

Disallow: /*/*/*/trackback/$

Sitemap: https://rana.ninja/sitemap_index.xml

Sitemap: https://rana.ninja/post-sitemap.xml

Sitemap: https://rana.ninja/page-sitemap.xml

Como experimento, probaremos el rastreo de https://rana.ninja/page/, que debería estar bloqueado según la última versión cacheada. Y es exactamente lo que ocurre: pese a haber un 5XX en el robots.txt, Google sigue respetando las reglas de la versión en caché.

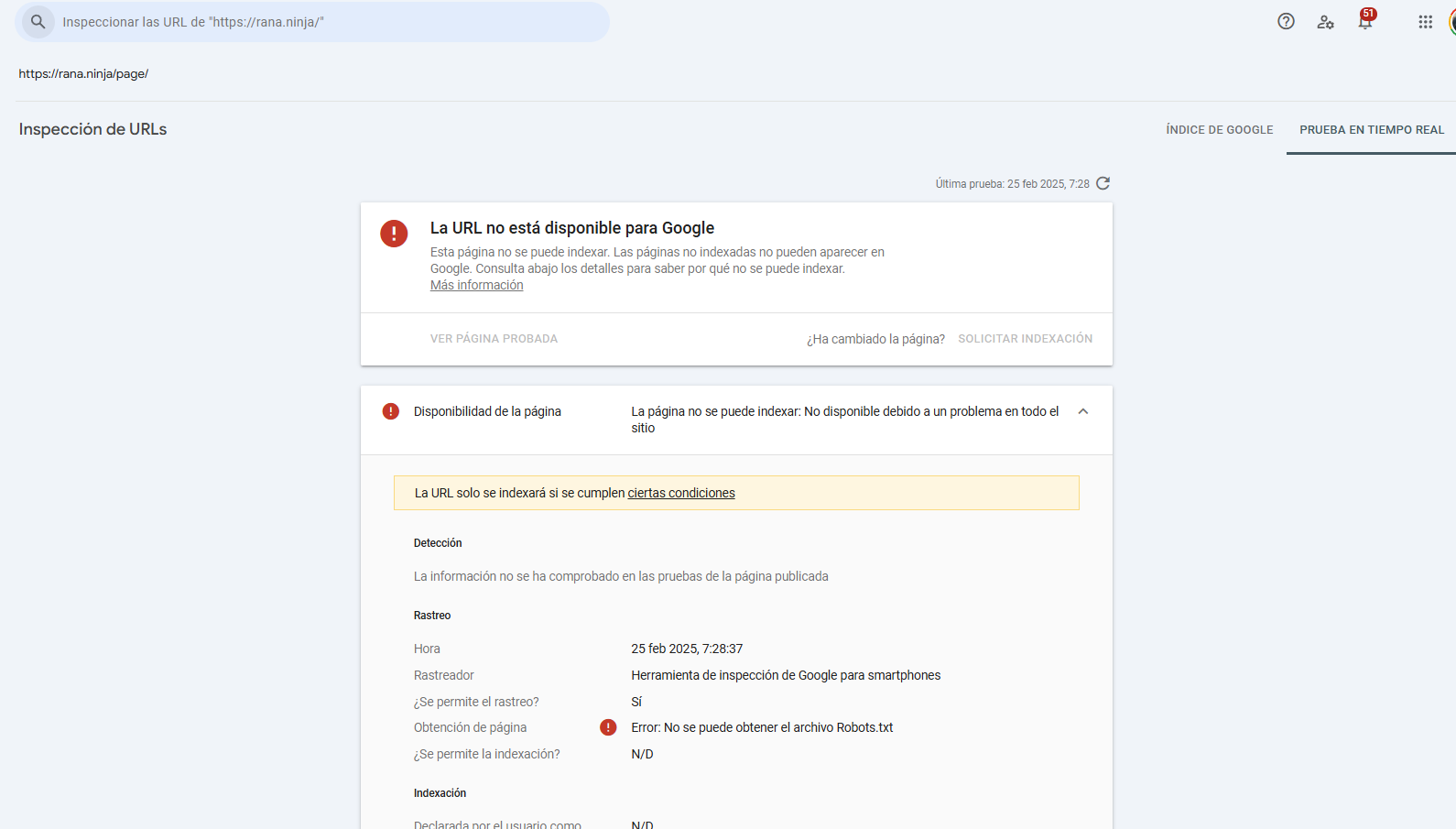

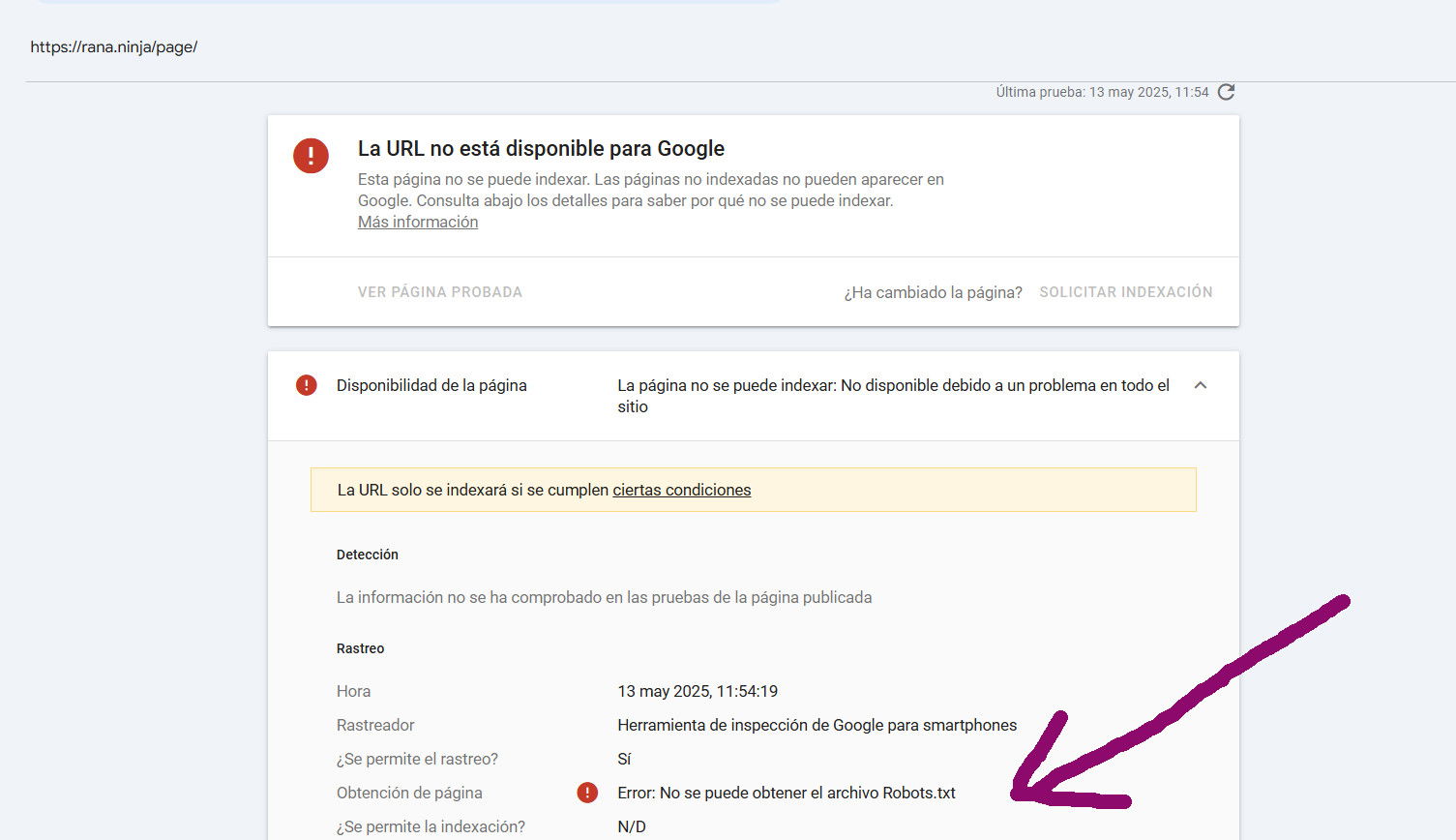

Se puede además comprobar que, aun probando en tiempo real con la herramienta de inspección de URLs, la URL no se puede rastrear pese al 5XX del robots.txt:

Los primeros días después de haber dejado el robots.txt con un 503, esto es lo que ocurre:

En resumen: no pasa absolutamente nada. Google se comporta con total normalidad usando la versión cacheada.

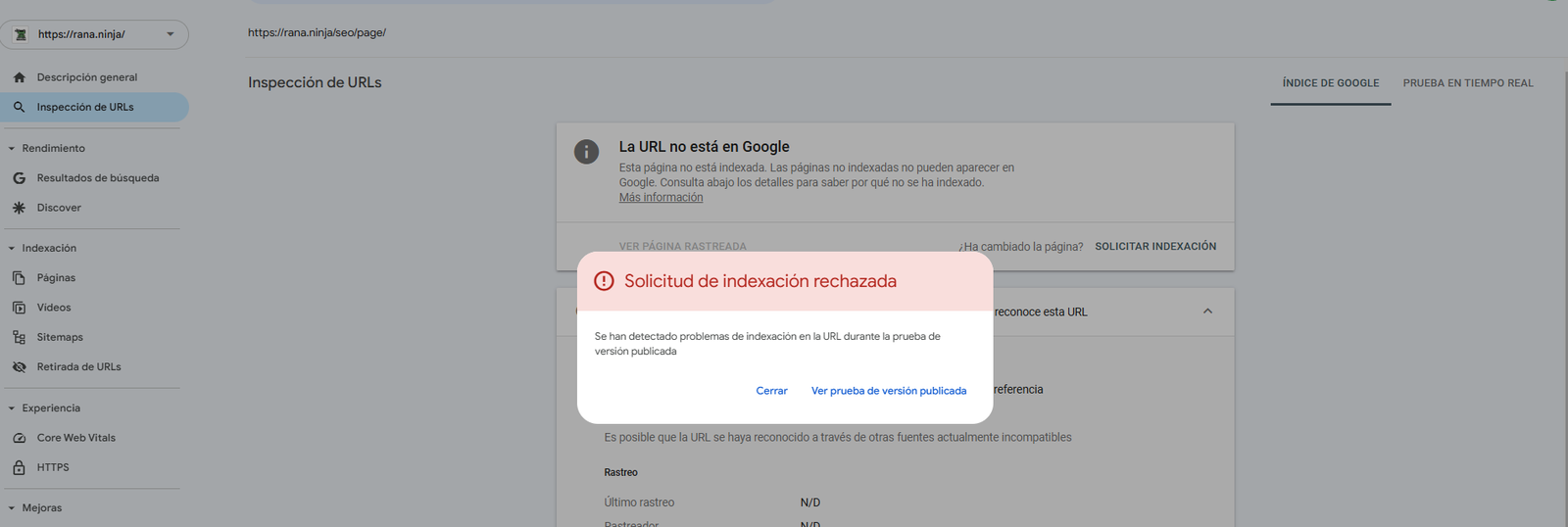

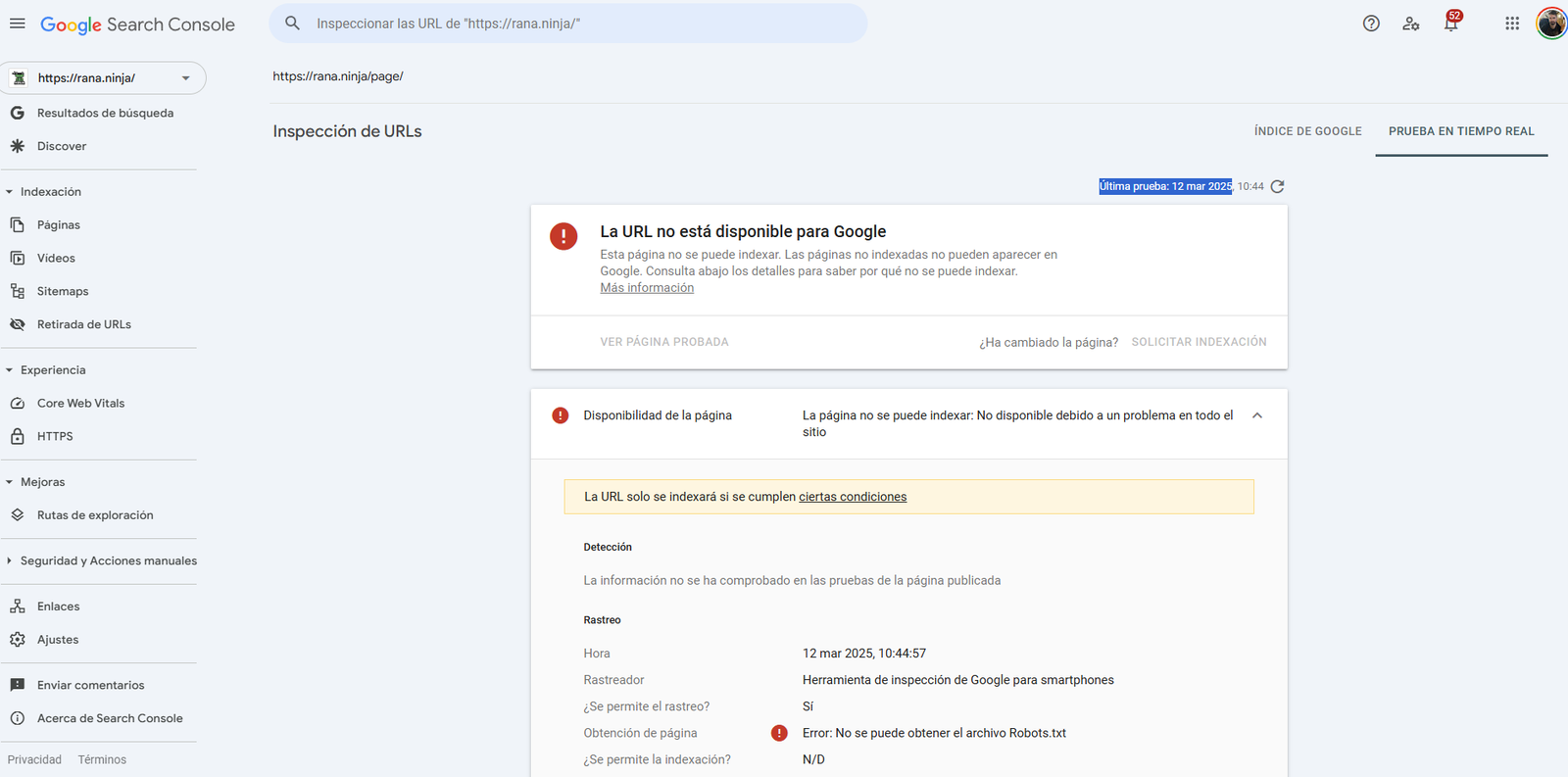

Tras 15 días con el robots.txt devolviendo un 503, Google sigue respetando las directrices cacheadas.

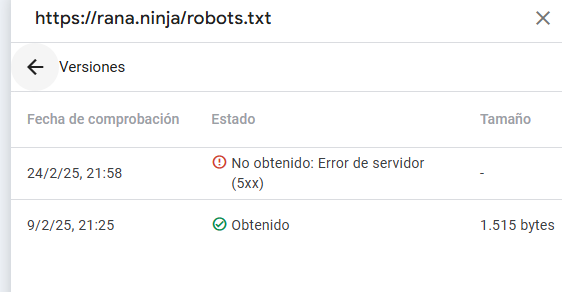

La única diferencia apreciable tras estos días es que Google Search Console ha eliminado la versión más antigua cacheada:

Queríamos comprobar si ocurría el desastre que anunciaba Gary Illyes en la web. Pasados más de dos meses, lo que encontramos fue lo siguiente.

Desaparece el historial de robots.txt cacheados:

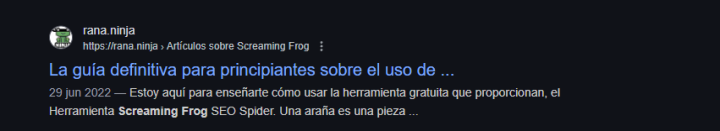

El contenido de la web es totalmente rastreable e indexable:

La página https://rana.ninja/page/ ya no aparece como bloqueada por el robots.txt:

Aquí viene lo importante. Aunque las URLs son rastreables, Google no permite la indexación:

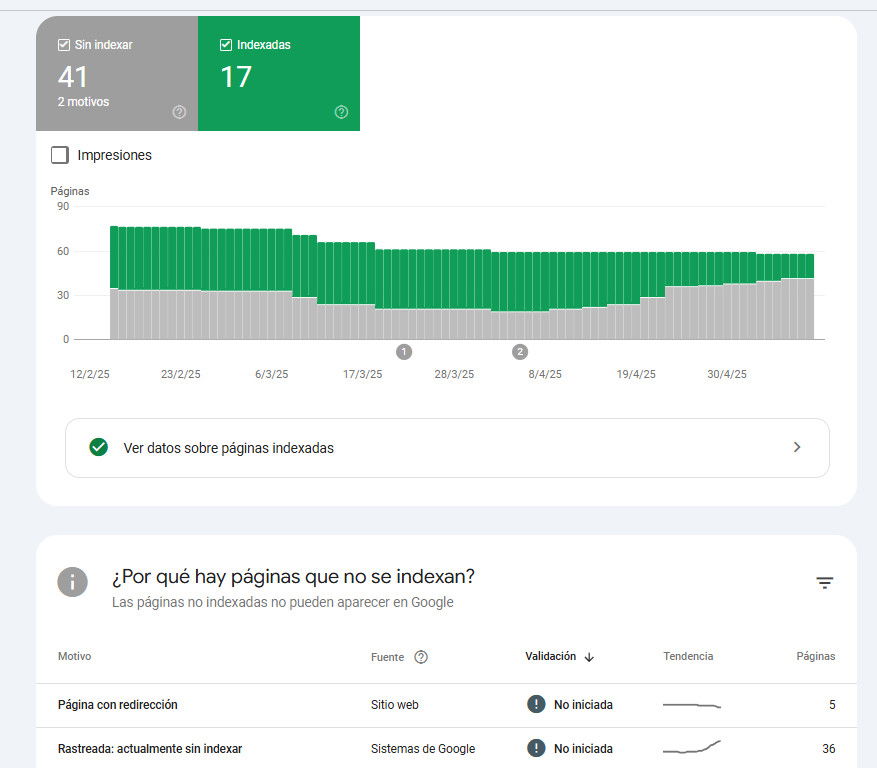

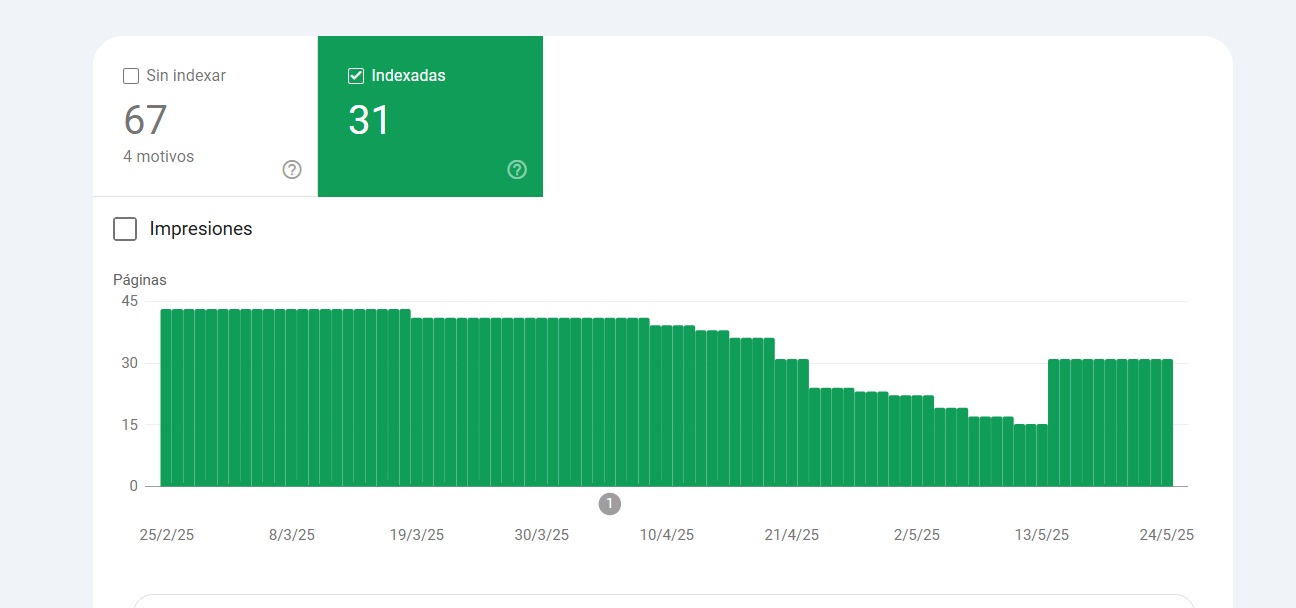

Tras varios meses de prueba, la indexación cae en picado:

Al parecer, pese a que la documentación dice que se toma como que no hay restricciones con el robots.txt y que se puede rastrear todo, la desindexación es algo que ocurre de forma progresiva tras el error 5XX continuado en el robots.txt.

Y aunque hay URLs que siguen mostrándose en Google:

Es solo cuestión de tiempo que esta desindexación fatal se extienda a lo largo de toda la web:

Lo que pensamos puede estar mejor o peor. Y aunque esta casuística sea algo marginal, estas son las conclusiones del estudio:

Edit 26/05/2025: En la siguiente imagen podemos observar que, una vez se restableció el robots.txt, las páginas vuelven a indexarse con normalidad.

Esto confirma que el daño no es permanente, pero sí lo suficientemente grave como para tenerlo muy en cuenta.

Te falta mi máster. Accede a una formación avanzada que te permitirá aplicar e implementar SEO en cualquier tipo de WEB

¡Accede al Máster de SEO Técnico!Si te ha gustado esta publicación, siempre me lo puedes agradecer dándome like en esta publicación de LinkedIn sobre este mismo artículo.