Siempre se mencionan. Pero, ¿sabes que son?

Los logs de una página web son registros que contienen información sobre las actividades realizadas en el servidor web que aloja la página. Cada vez que se solicita una página web, el servidor registra información sobre la solicitud en un archivo de registro. Estos archivos de registro se conocen como "logs".

Los logs pueden incluir información como la dirección IP del usuario que solicitó la página, el user-agent empleado (muy útil para detectar bots tanto de herramientas como de navegadores), la fecha y hora de la solicitud, el tipo de navegador utilizado, la página solicitada y el código de respuesta HTTP.

Los logs proporcionan información valiosa sobre el tráfico del sitio, e incluso sobre posibles ataques o qué consume el ancho de banda de un proyecto web. También nos sirven para detectar errores que se producen y otros problemas técnicos que pueden afectar el rendimiento y la seguridad del sitio, e incluso para hacer un análisis de la experiencia del usuario en la web.

Es posible que en los análisis que se realicen con nuestras herramientas de SEO, no detectemos picos de tráfico donde la web se sature y que realmente haya momentos en el que la web arroje errores 5xx, perdiendo oportunidades de negocio. Es por ello que los Logs son una fuente más de información útil para las auditorías.

Con los logs podemos detectar:

Tenemos que tener en cuenta, que aunque los logs sean muy útiles y convenga incluso tener copias de los mismos en otros lugares de almacenamiento. Estos archivos pueden ocupar bastante espacio del servidor. A lo largo del tiempo, al igual que ocurre con los backups, si no se mueven de sitio y no tienen un autoborrado, estos pueden acaparar todo el espacio del disco duro del servidor y provocar fallos importantes en el WPO de la web.

Hay distintas herramientas que permiten analizar los logs con interfaces amigables y agradables. Screaming Frog tiene una herramienta bastante completa. Es importante recalcar que dicha herramienta, es una herramienta distinta de Screaming Frog Spider, y su licencia debe pagarse a parte.

Así que primero veamos qué es un log, como analizarlo a mano para entenderlo, y luego lo comprobamos con distintas herramientas gratuitas, y por supuesto, de una forma más completa con las herramientas de pago.

Os muestro un ejemplo de un trozo de LOG, por lo general suelen ser archivos titánicos. Verlos de forma manual puede asustar bastante, y más aún verlo sin colores.

Pero es mucho más sencillo saber cuando nos pueden ser útiles si entendemos la información que contienen.

En primer lugar, tenemos que tener claro que lo que estamos es registrando información de cada petición o consulta que se realiza en nuestra web. Los datos del log es la información del servidor que tenemos disponible de todas y cada una de dichas consultas.

138.201.20.219 - - [21/Mar/2023:01:29:18 +0100] "HEAD / HTTP/1.0" 200 137 "-" "Mozilla/5.0 (compatible; SISTRIX Optimizer; Uptime; +https://www.sistrix.com/faq/uptime)"

88.203.186.24 - - [21/Mar/2023:01:34:19 +0100] "GET /seo-avanzado/ HTTP/1.0" 200 10093 "-" "Mozilla/5.0 (X11; Linux x86_64) AppleWebKit/537.36 (KHTML, like Gecko) HeadlessChrome/88.0.4298.0 Safari/537.36"

31.13.127.23 - - [21/Mar/2023:11:23:20 +0100] "GET /wp-content/uploads/og-nginx.jpg HTTP/1.0" 200 26824 "-" "facebookexternalhit/1.1 (+http://www.facebook.com/externalhit_uatext.php)"

66.249.64.119 - - [21/Mar/2023:13:16:31 +0100] "GET /servicios/departamento-seo/ HTTP/1.0" 200 8064 "-" "Mozilla/5.0 (compatible; Googlebot/2.1; +http://www.google.com/bot.html)"

52.114.75.216 - - [21/Mar/2023:09:48:23 +0100] "GET /wp-content/themes/sanchezdonate/images/favicon/favicon.png HTTP/1.0" 200 24353 "-" "Mozilla/5.0 (Windows NT 6.1; WOW64) SkypeUriPreview Preview/0.5 skype-url-preview@microsoft.com"

5.175.42.126 - - [21/Mar/2023:13:22:18 +0100] "POST /wp-cron.php?doing_wp_cron=1679401338.0174319744110107421875 HTTP/1.0" 200 706 "https://carlos.sanchezdonate.com/wp-cron.php?doing_wp_cron=1679401338.0174319744110107421875" "WordPress/6.1.1; https://carlos.sanchezdonate.com"

88.203.186.24 - - [21/Mar/2023:01:34:20 +0100] "GET /wp-includes/js/jquery/jquery.min.js?ver=3.6.1 HTTP/1.0" 200 31988 "https://carlos.sanchezdonate.com/seo-avanzado/" "Mozilla/5.0 (X11; Linux x86_64) AppleWebKit/537.36 (KHTML, like Gecko) HeadlessChrome/88.0.4298.0 Safari/537.36"

54.39.177.173 - - [21/Mar/2023:09:36:13 +0100] "GET /x-robots-tag/ HTTP/1.0" 301 897 "-" "Mozilla/5.0 (compatible; YaK/1.0; http://linkfluence.com/; bot@linkfluence.com)"

192.168.1.1 - jaimito.soler [21/Mar/2023:15:23:45 -0700] "GET /pagina-secreta HTTP/1.1" 200 5120 "https://carlos.sanchezdonate.com/seo-avanzado" "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/96.0.4664.110 Safari/537.36

Es normal que este código asuste, es por eso que está diferenciado por colores. Así que voy a exponer parte por parte, juntando distintos ejemplos para que se entienda:

Mejor que el un editor de texto habitual, se puede ver con el LogPad de CloudVyzor, el cual hace más legible los vistazos manuales.

Con esta herramienta, podremos ordenar todos estos datos para poder analizarlos y sacar conclusiones relevantes.

Una vez tenemos los datos importantes vamos a ver lo más básico y cada una de las pestañas más interesantes:

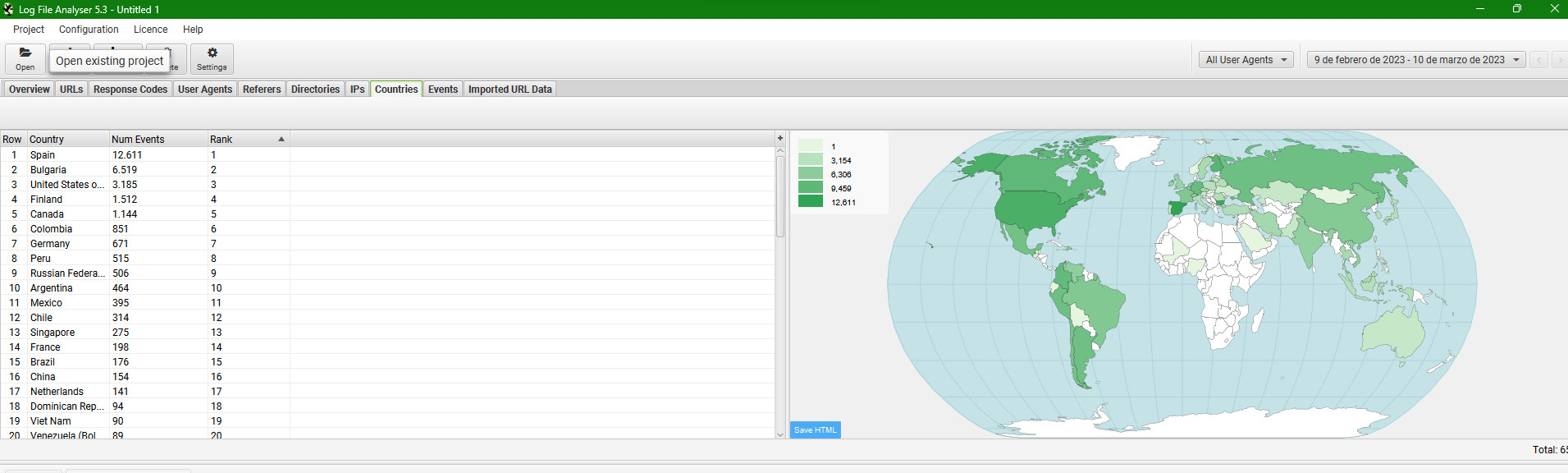

Nos permite tener una gráfica del tráfico en nuestra web, del porcentaje de error y las fechas donde se han detectado dichos errores. Podremos segementar por distintos user-agents y fechas.

Es importante saber que por defecto la herramienta no los recoge todos. Por lo que es posible que de primeras no detectemos un tráfico inusual de User-agents maliciosos

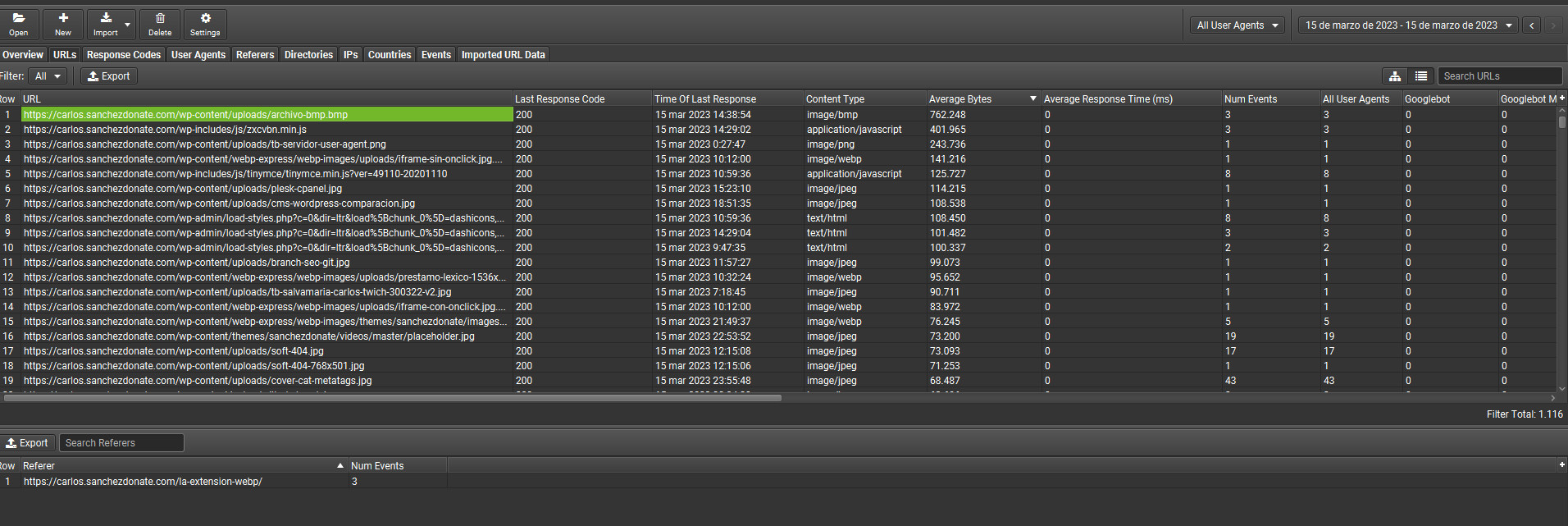

Nos permite detectar de una forma sencilla que archivos de nuestra web están haciéndonos gastar mayor ancho de banda. Desde qué páginas e incluso por qué.

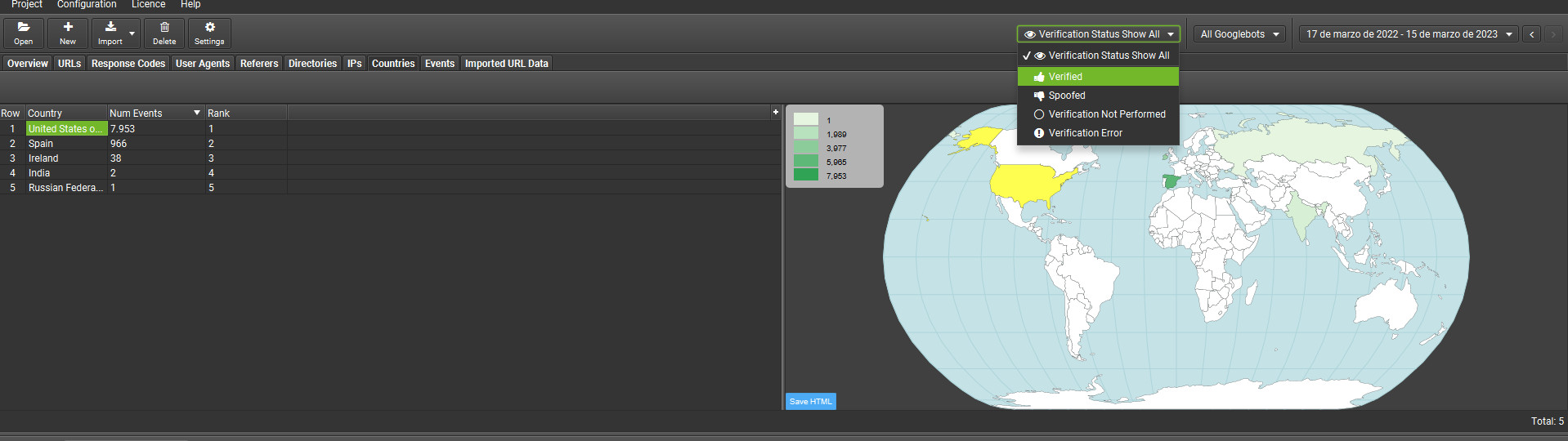

Nos permite analizar desde qué lugar según nuestro servidor nos llega la petición. Podréis comprobar con esta herramienta que las peticiones reales de Googlebot vienen desde EEUU. Entonces podremos detectar los falsos rastreos para eliminarlos.

Para que esto nos funcione, tendremos que ir a Project y a verify bots. Tardará aproximadamente 1 minuto y lo podréis comprobar de forma rápida.

Realmente esos serían los aspectos más básicos a la hora de analizar logs. Podemos comprobar si Googlebot está llegando a zonas que no debería, saltándose algún "nofollow", o si realmente está accediendo desde otro lugar. También nos vale para comprobar si nos rastrean de forma persistente diferentes herramientas o usuarios.

Evidentemente, lo expuesto aquí es solo una parte del potencial que tiene la herramienta de Screaming Frog. Existen alternativas gratuitas, pero no las expongo porque en realidad no trabajo con ellas habitualmente.

Te falta mi máster. Accede a una formación avanzada que te permitirá aplicar e implementar SEO en cualquier tipo de WEB

¡Accede al Máster de SEO Técnico!Si te ha gustado esta publicación, siempre me lo puedes agradecer dándome like en esta publicación de LinkedIn sobre este mismo artículo.