Para poner el mejor Robots.txt en una web hay que entender qué es el robots.txt

El robots.txt es un fichero que se usa constantemente en el mundo del SEO, en este artículo se verá como hacer un buen robots.txt, sin embargo, antes de "mostrar un robots.txt" infalible o de calidad, es necesario ir a la base, qué es exactamente y en qué consiste.

El robots.txt es un archivo que se utiliza desde 1994 como método para evitar que ciertos Bots/Spiders/Crawlers/Rastreadores/user-agent (en este caso todo significa lo mismo), rastreen una parte de una web. También se intenta utilizar para variar la frecuencia de rastreo, aunque debido a la falta de estandarización no se consigue.

El robots.txt es un fichero con recomendaciones de rastreo que los rastreadores interpretan a su voluntad.

De hecho es importante recalcar que es simplemente un archivo en un formato de texto que los Crawlers pueden leer para hacerle caso. Recalco pueden, porque no evita en ningún caso que se pueda rastrear una web, sino que es simplemente como una guía de rastreo para el bot, la cual puede ignorar a voluntad. Por lo que aun prohibiéndole a un User-agent el rastreo de la web desde el robots.txt, este podría saltárselo. Por ejemplo Internet Archive lo ignora.

El robots.txt es un fichero que pretende ser un estándar, de hecho Google en 2019 hizo bastantes esfuerzos por incluirlo como estándar en la IETF debido a que no todos los bots leen el archivo de la misma forma y cada Crawler interpreta las directivas que considera.

Es fácil preguntarse entonces qué utilidad tiene este archivo si cada user-agent hace lo que buenamente quiere. Pero la realidad es que los motores de búsqueda más conocidos como Google, Baidu, Yandex o DuckDuckGo si respetan este estandar, o al menos las directivas más importantes.

Entonces nos permite controlar el rastreo de los motores de búsqueda, pudiendo conseguir así una mejora del Crawl-Budget.

El robots.txt sirve para impedir el rastreo de los directorios o archivos que nosotros consideremos por parte de ciertos motores de búsqueda. Esto no impide la indexación.

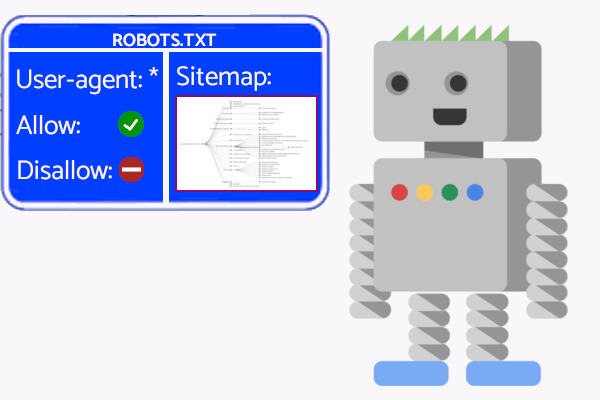

También nos sirve para indicar los sitemaps a los motores de búsqueda, aun cuando no los hemos indicado por medio de la Search Console o "Buscador" Webmaster.

Debemos evitar impedir el rastreo de archivos CSS, JavaScript o cualquier archivo que pueda ser crítico para el rendimiento o entendimiento de nuestra web, en primera instancia podemos pensar que así el motor de búsqueda no pierde el tiempo con esos archivos, pero podríamos por ejemplo impedir al motor de búsqueda cargar el CSS que hace una web Responsive.

Por otro lado, jamás se debe poner un Disallow para evitar el rastreo de códigos de respuesta 404 o de páginas no indexables. Ya que Google no será capaz de leer ni los códigos de respuesta, ni si la página es noindexable. Aunque se especifique por medio del x-robots.

Por orden de importancia

# : Sirve para poner comentarios que no serán interpretados por los rastreadores (Para que solo entre humanos nos entendamos).

Ejemplo:# Esto sería un comentario dentro de un robots.txt que no tendría efecto alguno para los crawlers.

$ : Sirve para indicar el final de una coincidencia. Es decir, para especificar como deben terminar los elementos a los que hacemos mención.

Ejemplo:Disallow: /categoria/$

* : La definición de libro dice "Designa 0 o más instancias a cada caracter". Traducido a cristiano significa "todo lo que haya aquí".

Ejemplo:User-agent: *

Disallow: */ejemplo/*

La línea User-agent identifica al crawler al que se le aplican las reglas. Los User-agent se pueden agrupar para definir las reglas en conjunto.

Una vez se pongan unas directivas después de los User-agents, las reglas funcionarán en esos User-Agents agrupados.User-agent: Googlebot

User-agent: Sogou

User-agent: sogou spider

User-agent: Screaming Frog SEO Spider

User-agent: Applebot

User-agent: DuckDuckBot

Allow: /

User-agent: 360Spider

User-agent: msnbot

User-agent: Twitterbot

User-agent: Pingdom.com bot

User-agent: baiduspider

User-agent: Yahoo! Slurp

Disallow: /

En este ejemplo podríamos ver/entender más fácil como funciona, si entendemos que los de verde tendrían permitido el rastreo y los de rojo no. Ya que las directivas funcionan en base a los User-Agents que se tienen por encima hasta que haya otra directiva.

Listado no oficial de user-agents

Es la directiva que le da sentido al robots.txt , sirve para especificar las rutas que los bots no deberían poder rastrear.

Si no hay ningún disallow, se permite rastrear por defecto, pero esta directiva nos sirve para permitir contenido dentro de las restricciones del disallow.

En caso de conflicto gana la directiva más permisiva.

Sirve para indicarle a todos los rastreadores donde están tus Sitemaps. Es de los comandos más útiles dentro del propio robots.txt y es inmune al comando User-agent. Es decir se puede poner incluso arriba del todo y será leído por todos los rastreadores.

Para los más curiosos añado mi artículo: directivas que no son leídas por Google.

El Robots.txt siempre debe estar en la carpeta raíz de un proyecto y es necesario que se llame robots.txt

A nivel técnico os recomiendo la propia guía de Google paso a paso acerca de como funciona la codificación dentro del robot.txt ya que es muy completa.

Os recomiendo utilizar el probador de Robots.txt de Google, el de Merkle o incluso Yandex tiene el suyo propio. De hecho lo ideal es ir construyendo el robots.txt en estas herramientas, para poder ir comprobando si tiene el efecto que deseamos.

Toda la introducción sirve para esta pregunta. Es bastante habitual rastrear páginas para encontrar: "el mejor robots.txt para WordPress|shopify|la tecnología que sea". y la realidad es mucho más simple.

El robots.txt es una herramienta para bloquear el crawleo de los rastreadores que lo interpreten (por ejemplo los más famosos motores de búsqueda). Por lo cual debe utilizarse para eso y para el Sitemap.

El mejor robots.txt es el que te impide rastrear lo que quieres impedir que se rastree si es que quieres impedir que se rastree algo.

Es decir, no por ser un aspecto técnico del posicionamiento web hay que hacer un robots.txt gigante, en muchas ocasiones lo más inteligente es dejarlo en blanco y permitir el rastreo de toda la web.

Así que lo único que debe tener tu robots.txt es un disallow hacia las url que no quieres que un motor de búsqueda pierda el tiempo rastreando.

En caso de no haber ninguna, no se debe añadir nada más. Y así emplear el tiempo en otras cosas mas útiles y necesarias para el SEO.

Pues tienen sentido cuando queremos bloquear el rastreo de páginas que nos generen 0 interés o nos puedan fastidiar el presupuesto de rastreo.

También tiene sentido bloquear ciertos directorios que pueden generar error y confusiones en los bots, por ejemplo, muchos productos de Cloudflare generan un directorio llamado /cdn-cgi/ que debería ser bloqueado para evitar errores o problemas.

El human.txt no tiene mucho que ver con el robots.txt, pero me parece una iniciativa bonita e interesante. Ya que nos molestamos en hacer robots.txt para bots, y además en muchas ocasiones se hacen robots.txt totalmente inútiles, por lo menos se puede utilizar esta iniciativa para indicar aquellos que han trabajado en esa página.

Te falta mi máster. Accede a una formación avanzada que te permitirá aplicar e implementar SEO en cualquier tipo de WEB

¡Accede al Máster de SEO Técnico!