Claves para optimizar tu presencia en inteligencias artificiales y aprovechar su impacto creciente como SEO

Hace un tiempo que se está "matando el SEO" aún teniendo Google la cuota mayoritaria de mercado respecto a consultas online en cuanto a productos.

No obstante la IA va cogiendo protagonismo y afloran los vendehumos clasificándose como "expertos" (en algo que no tiene ni 2 años) en "GEO" "AIO" o siglas que te gusten para definir el SEO en LLMs (Modelos Lingüísticos Grandes).

Ante esto quiero arrojar un poco de luz en cuanto a cuestiones que nos han funcionado respecto a clientes y cómo se debe o puede trabajar el mejorar el "posicionamiento" en las inteligencias artificiales. Donde no sólo es importante que te mencionen, sino lo que dicen sobre ti.

Para ello es importante entender a las inteligencias artificiales, y pese a que a los Nerds nos guste probar alternativas y aunque existen múltiples tipos de inteligencia artificial —visuales, conversacionales, predictivas, generativas— el mayor peso actual en consultas de información lo tienen los LLM generalistas, donde ChatGPT indudablemente tiene la mayor cuota de mercado y por eso me voy a centrar en él.

De resumen podríamos decir estas tareas para el GEO y su impacto:

| Acción | Impacto en LLMs | Observaciones |

| Optimizar SEO técnico tradicional (HTML limpio, CWV, arquitectura lógica, hreflang correcto) | Alto | Base imprescindible; la mayoría de mejoras en LLM provienen de esto. |

| Contenido textual claro y estructurado (evitar ironías y sarcasmos) | Alto | Favorece que el LLM entienda y reformule bien tu contenido. |

| Menciones de marca/producto en otros sitios (con o sin enlace) | Alto | Aumenta la probabilidad de que el LLM te reconozca como autoridad. |

| Comparaciones, tablas y listados claros | Alto | Los LLM extraen y reformulan mejor datos organizados. |

| Controlar el abuso del rastreo de la web por medio del servidor | Alto | Protege recursos, pero bloquear puede restar visibilidad si no se hace de forma selectiva. |

| Evitar CSR para contenido clave | Alto | LLMs no ejecutan JS; mejor SSR o HTML plano para lo importante. |

| Crear contenido específico solo visible o invisible para IAs (ej. con GEOhat LLM) | Alto | Puede reforzar contexto sin afectar experiencia del usuario. |

Uso de data-nosnippet para evitar que info sensible aparezca en SERPs | Alto | Útil para proteger datos, pero limita visibilidad si se abusa. Y se debe combinar con otras estrategias de ocultación. |

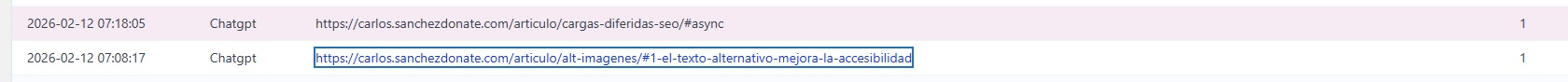

| Revisión de logs para detectar rastreo IA | Alto | Permite tomar decisiones sobre accesibilidad y control de bots. |

| Campañas de likes/dislikes en ChatGPT | Bajo | No influye en el ranking ni en la aparición de URLs. |

Uso de llms.txt o ai.txt | Nulo | No es estándar ni tiene efecto real en rastreo o ranking. |

| Acuerdo Shopify–ChatGPT | Circunstancial | Ventaja temporal para tiendas Shopify; no aplicable a todos. |

Veamos los puntos principales sobre la obtención de información que tiene una Inteligencia Artificial sobre tu página web.

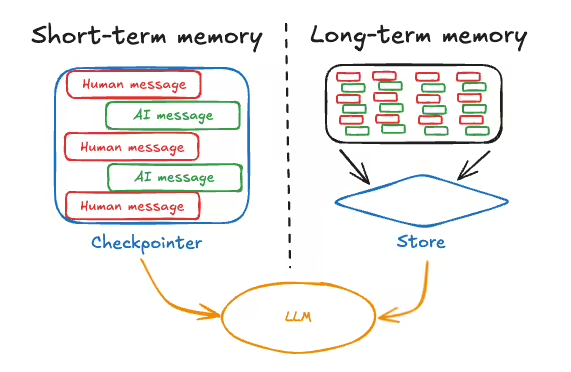

ChatGPT posee una memoria a largo plazo derivada de su proceso de entrenamiento, que incluye la información con la que ha sido previamente instruido, así como el conocimiento accesible a través de internet.

No obstante, ChatGPT puede almacenar información sobre el usuario, salvo que este modifique la opción en Configuración > Personalización > Memoria.

De este modo, además de la información de carácter general que conserva a largo plazo, el modelo puede utilizar datos procedentes no solo de la conversación actual, sino también de interacciones anteriores, con el objetivo de ofrecer respuestas más adaptadas a cada usuario.

Esto le permite identificar, por ejemplo, si la persona prefiere respuestas más breves o más extensas, si requiere un nivel técnico elevado o, por el contrario, explicaciones más básicas (dependiendo del tema). Asimismo, puede ajustar su forma de redacción a la capacidad de comprensión y al estilo de lectura del usuario.

En consecuencia, si un usuario realiza habitualmente consultas sobre cocina vegana y ecologismo, el sistema podrá considerar esta información al formular recomendaciones de productos o servicios, con el fin de optimizar la relevancia y la satisfacción de la respuesta.

Se considera que ChatGPT puede emplear distintos motores de búsqueda de manera no exclusiva, ajustando su elección según el perfil del usuario, la naturaleza de la consulta y, potencialmente, la versión del modelo (GPT o LLM específico) utilizada.

Según distintos compañeros de sector,en distintos momentos afirman que: ChatGPT utiliza los resultados de Google, otros dicen que los de Bing.

Según ChatGPT se contradice diciendo que solo lo hace mediante herramientas o que utiliza Bing con ChatGPT plus con navegación.

Vamos a quedarnos en el punto medio y con que hay que tener cuidado con la información que aparece en las SERPs, ya que esta información podría ser utilizadas directamente por las inteligencias artificiales, sin necesidad de meterse en nuestra web. Es decir, podrían sacar información nuestra aunque utilicemos el robots.txt. Para bloquear información sensible de aparecer en las SERPs podemos utilizar el atributo data-nosnippet.

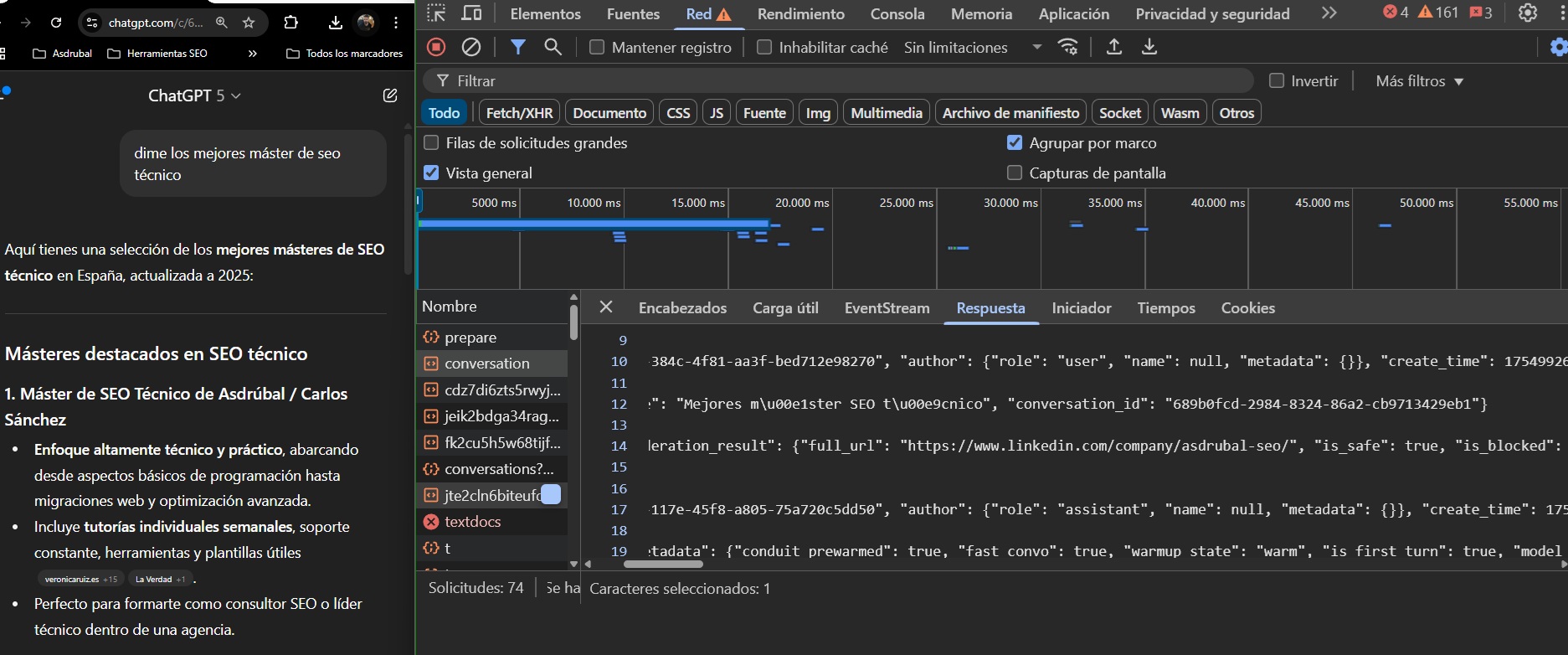

Aún en ChatGPT5 se puede ver el archivo JSON del proceso de pensamiento y consultas que realiza ChatGPT para hacer una respuesta. Esto nos podría servir para ver desde distintos usuarios la investigación más habitual que hace ChatGPT ante consultas que nos pueda interesar para nuestro negocio y actuar en consecuencia.

Explicaré el proceso paso a paso para sacar esta información en mi máster de SEO Técnico.

La mayoría de inteligencias artificiales si comprobamos los Logs en varias webs que hemos probado lo respetan, no obstante tenemos la desventaja de lo que he comentado en las SERPs. Mas allá de que mucha gente pone user-agents o las reglas de forma incorrecta.

Luego estaría el debate de si es conveniente bloquear información a los LLMs que nuestra competencia si le da.

Desde el auge de las inteligencias artificiales el rastreo de las webs está subiendo exponencialmente. Tanto por parte de los propios modelos de lenguaje en su aprendizaje como con las consultas del usuario. O por parte de usuarios que hacen su nueva herramienta de IA o realizan automatizaciones haciendo crecer por mucho el rastreo de las páginas webs.

Alvaro Fontela me confesó que empieza a ser un problema en servidores y es normal que CEOs de Hostings y CDNs como Cloudflare estén tomando la decisión de cortar las alas por medio del servidor a las inteligencias artificiales.

No obstante hay que tener cuidado y más si estos cortes son sin tu previo conocimiento de ello. Porque se te puede estar quitando la oportunidad de mejorar el posicionamiento en estos LLMs.

Lo mejor y recomendable es consultar a tu proveedor de hosting y comprobar el acceso a tu web cambiando el user-agent a los habituales de las IAs (lo puedes hacer con la devtools) para comprobar si están bloqueando IAs interesantes para ti.

Hay que saber ver también la otra cara de la moneda y comprobar que tantas IAs no están tumbando tu web.

En el caso de que eso sea así, siempre será mejor bloquear desde el servidor que por medio del robots.txt.

Otro añadido a la complejidad del SEO estos días, es que si bien habíamos conseguido que Google renderizase JavaScript y pudiese leer nuestro contenido, las Inteligencias Artificiales a día de hoy no lo hacen.

Resulta mucho mas caro rastrear webs con JavaScript y ya consiguen su propósito sin hacerlo. ¿Por qué iban a gastar más dinero estando en pérdidas solo para poder acceder a tu web cuando los usuarios están satisfechos?

Por lo que el CSR no es una buena opción para posicionar en LLMs.

Otro aspecto que hemos podido comprobar es que ChatGPT sigue los hreflang parecido a Google. Aunque supuestamente haya accedido a la página en un idioma, te puede sacar contenido que solo está en la versión alternativa del otro idioma sin decirte que ha rastreado esa otra parte.

En mi web por ejemplo comenta que las fuentes es la página sobre mi en inglés pero me saca información que sólo está en el sobre mi Español.

Está comprobado que ChatGPT puede darle al usuario páginas que están en noindex (en todas las pruebas estas páginas eran accesible por medio de enlazado de páginas indexables).

También está probado que a diferencia de Google ChatGPT puede añadir enlaces con el Hash si esa URL es enlazable

Aunque no quiero que se pierda el foco ya que la mayor parte del trabajo en esto es realizar las tareas de SEO tradicional bien, de hecho en AI Overview es casi todo, si que hay aspectos importantes a tener en cuenta.

Javier Bermudez me comentó sobre 4 verticales que le recomendó a un compañero agobiado, ya que aunque era SEO no sabía por donde empezar para optimizar el "GEO".

Entonces planteó a tener en cuenta:

Auditoría de accesibilidad

Que el server no bloquee los bots de IA, identificarlos, ver qué herramientas de análisis de logs vas a usar, gobernanza de datos sobre qué quieres que tenga acceso o no la IA, revisar el HTML y los CWV para determinar que la IA rastrea y entiende bien el contenido

Auditoría de visibilidad

Usar herramientas como el Brand radar de ahrefs, AI Search Toolkit de SEranking, o herramientas más caseras y determinar el punto de partida, qué info tienen los LLMS de ti

Auditoría de analítica

Como se atribuye la IA en tu GA4, establecer embudos, asistencia de la IA a la conversión en otros canales, análisis de logs del tiempo en el que publicas y la IA lo rastrea o lo menciona, definir KPIs de éxito ligados a factores de accesibidad/visibilidad/conversiones

Proyección de trabajo

Mejora de contenido, linkbuilding, menciones y todo lo que es el seo más tradicional.

Lo plasmo tal cual, como buen roadmap que es, pero debemos tener en cuenta los siguientes aspectos que son específicos de LLMs más que el SEO tradicional (que repito, es la mayor parte).

Aunque existen múltiples tipos de inteligencia artificial —visuales, conversacionales, predictivas, generativas— el mayor peso actual en consultas de información lo tienen los LLM generalistas (ChatGPT, Gemini, Claude, Mistral).

Estos modelos trabajan sobre grandes volúmenes de texto y tienden a dar respuesta rápida y eficiente (eficiente quiere decir rentable para ellos, barata en tiempo real, es decir, sin procesar formatos más complejos como vídeo o audio) salvo que ya tengan una transcripción previa en su entrenamiento.

Entonces:

Por otro lado, el KW research tradicional puede servirnos como guía o para entender el negocio, no como una "biblia manual a seguir", no obstante si que podemos realizar "acciones" medibles y objetivas que nos ayuden a mejorar tanto en el SEO tradicional, como a que las IAs entiendan mejor nuestro contenido, lo podemos hacer por ejemplo identificando páginas semánticamente similares con Screaming frog.

Nunca he sido muy fan del Linkbuilding y mi pensamiento era que Google le iba a ir quitando importancia, de hecho es cierto. Pero ahora los LLMs si que tienen algo en cuenta, y no son tanto los enlaces, que influyen y sobre todo pueden traer tráfico cualificado, sino que las menciones de otros hacia ti (sin necesidad de enlace) pueden ser clave para que los LLMs te tengan en cuenta como autoridad.

Por lo que cuando hagas Linkbuilding si lo haces, ten muy en cuenta que mencionen la marca o el producto, que se pueda acceder a ti con esa información gracias al branding sin necesidad de un enlace.

Tanto para tu página como para contenido que publiquen otros sobre ti.

Estos serían algunos consejos que te pueden funcionar y que nosotros hemos comprobado una mejora sustancial en la adquisición de usuarios por medio de los LLM, más una parte de branding que no sabemos medir:

En el resto de aspectos Al igual que con SEO tradicional para Google, un texto claro, estructurado y sin ambigüedades ayuda a que el modelo lo procese correctamente.

Ironías, sarcasmos y dobles sentidos tienden a ser malinterpretados por LLM y pueden llevar a que la idea principal no se extraiga o se omita. Esto recuerda a la época del clickbait “negativo” en Google, donde titulares irónicos no siempre se entendían como tal y servían para posicionar, en este caso pueden jugar en tu contra.

En cualquier caso, el resto de optimizaciones de contenidos serían exactamente los mismos que funcionan en el SEO tradicional.

No obstante, es posible que algunos de estos consejos te cueste un poco ponerlos en la web y que vean dichos textos todos los usuarios. Por eso, de cosecha propia hice un plugin que se llama GEOhat LLM, que te permite:

Veamos que hay unos cuentos

Nunca han funcionado, no son un estándar y nunca se esperará que funcione. La gente se empeña en su uso mas allá de que portavoces de distintas empresas que tienen estos LLMs lo afirmen, que se demuestre que no.

A la gente le gusta el camino facil y es bastante habitual ver webs con plugins de este tipo que realmente no funcionan ni sirven en absoluto.

Ni da contexto ni mejora nada. ChatGPT no rastrea tu web a ver donde encuentra indicaciones. Si le preguntas sobre un producto irá a la página del producto y si le preguntas por la empresa irá a por el "about us" la "información legal" y lugares lógicos donde está tu información.

Si necesitas dar contexto para que se entienda la web, o lo tienes en CSR y por eso no lo lee, o tu web necesita una optimización de contenido.

Ni el llms.txt ni el ai.txt funcionan.

Y lo cierto es que tiene lógica que no lo usen.

Cada fuente interpreta el correcto llms.txt con distintos propósitos y deseos mágicos..

Algunos comentan que es para indicarles la importancia de las páginas, otros afirman que es para indicar si se les permite entrenar el modelo o no y que hacer en la web por medio de distintas directivas, otros para ofrecer un resumen rápido y detallado de que hay en la web.

En cualquiera de los casos, tomemos el estándar de indicar las páginas como el correcto, como si fuera un Sitemap (que ya existen) pero para los LLMs con alguna indicación más.

¿Por qué iba a tomar las directrices teniendo la propia barra de navegación y los resultados de búsqueda en distintos motores de búsqueda para sus consultas.

La realidad es que no lo necesitan y no les ayuda en nada, ni a ellos ni a los usuarios.

Parece algo más pensado para inversores y para comprar acciones de estos dos gigantes y luego venderlos antes de que fracase. Pero en principio se trata de un acuerdo donde los productos de Shopify se integrarán directamente en ChatGPT donde openAI se llevará comisiones.

Prácticamente parece un afiliados.

No obstante aunque hay beta, no sabemos si será bien acogido por los usuarios y funcionará o quedará en fracaso, pero es posible que Shopify presente una ventaja competitiva a corto plazo en ChatGPT a cambio de pagarle comisión a OpenAI por venta.

¿Por qué creo que funcionará menos? Creo que al final los usuarios le pasarán igualmente los productos de las webs que les interesan a ChatGPT (estén o no en Shopify) y le pedirán consejos o recomendaciones.

La gente sigue usando Google como buscador, y a ChatGPT más como asesor y comparador, a la gente le gusta tener la sensación de que compara y decide.

En cualquier caso esta es una opinión subjetiva mía, ninguno somos futurólogo y habrá que ver como evoluciona, pero el acuerdo existe y es real. Aunque aún no se ha comunicado fecha exacta ni oficial.

El sistema de “me gusta” o “no me gusta” en ChatGPT no mejora el posicionamiento de una web ni altera la visibilidad de un contenido en los resultados que ofrece a otros usuarios.

Estos botones sirven para:

Lo que no hacen:

En resumen: dar “like” o “dislike” sirve para mejorar la experiencia de usuario y la calidad del servicio, pero no es un truco para mejorar el SEO ni la posición de una web en ChatGPT.

Es decir, aunque suene fácil y bonito, por desgracia no funciona mucho.

OpenAI no procesa votos individuales uno a uno para modificar salidas, sino que agrega grandes volúmenes de datos y revisa de forma controlada. Esto hace que sea prácticamente imposible “manipular” el sistema con una campaña coordinada de dislikes.

No obstante, si crees que con alguna query a pequeña escala puede funcionar, tampoco pierdes nada al intentar este tipo de campañas.

El 4 de agosto Metehan Yesilyurt publicó un artículo titulado "Breaking: Perplexity’s 59 Ranking Patterns and Secret Browser Architecture Revealed (With Code)".

El artículo es un tanto extenso y ahí lo dejo para quien quiera profundizar, no obstante, salvo ciertas peculiaridades, las cuestiones más importantes no hace más que reforzar lo que se venía haciendo. Vamos a los que considero los puntos claves de su artículo:

Esto es sin duda lo más diferenciador y que más me ha llamado la atención. Estos son sus consejos:

Debes actualizar periódicamente y añadir información nueva para evitar el decaimiento de ranking. Por lo visto, Perplexity degrada rápido lo que considera “viejo” o “no actualizado”.

Recuerdo que tenemos un generoso tutorial de embeddings hecho por Juan Gonzalez Villa que hizo para nuestro máster de SEO Técnico.

Es decir, evitar en la medida de lo posible contenido duplicado, superficial y Feedbacks negativos.

Las respuestas mejoran con un buen entramado de enlaces internos con artículos relacionados para mantener la autoridad semántica.

Si, he comentado ya lo del LinkBuilding, pero como este apartado una síntesis del artículo de Metehan debo ponerlo, ya que el también le ha dado bastante importancia.

En el artículo pone un listado de dominios "white list" donde puede ser interesante salir. Spoiler, siempre lo fue.

El SEO para LLMs (AIO/GEO) no sustituye al SEO tradicional, pero exige entender cómo las inteligencias artificiales —especialmente ChatGPT— obtienen y procesan la información. Estos modelos no siempre rastrean tu web, pueden basarse en lo que aparece en las SERPs, respetan en general el robots.txt pero no ejecutan JavaScript, y valoran más menciones y contexto claro que enlaces puros. Optimizar para ellos implica asegurar accesibilidad a la información clave, controlar la visibilidad y el branding, y crear contenido textual estructurado, comparativo y sin ambigüedades.

Los mitos como el uso de llms.txt o la manipulación de likes/dislikes no funcionan para mejorar posicionamiento. El enfoque debe centrarse en un buen SEO técnico, adaptación de contenidos al formato que las IAs entienden y gestión estratégica del acceso que se les da, sin perder de vista que el grueso del trabajo sigue estando en la optimización web clásica.

Te falta mi máster. Accede a una formación avanzada que te permitirá aplicar e implementar SEO en cualquier tipo de WEB

¡Accede al Máster de SEO Técnico!